Quelques noms qui ont marqué la pensée statistique

| Site: | IRIS - Les cours en ligne de l'UT2J |

| Cours: | UOH / Statistique et Psychométrie en L1 |

| Livre: | Quelques noms qui ont marqué la pensée statistique |

| Imprimé par: | Visiteur anonyme |

| Date: | jeudi 5 mars 2026, 10:17 |

1. Pierre-Simon de Laplace (1749-1827)

Grand mathématicien et physicien, Laplace s'est notamment illustré, parmi de nombreux autres faits d'armes scientifiques, en montrant pour la première fois la stabilité du système solaire et sa conformité aux prédictions newtoniennes. Laplace nous intéresse ici pour plusieurs raisons : par sa position déterministe ferme et par son invention de la « fonction d'erreur ».

Laplace introduit ainsi l'idée d'un intellect capable d'exploiter ce qu'il croyait être la nature déterministe du monde, le fameux « démon de Laplace » :

Toutefois, il convient de prendre garde à ne pas prendre Laplace pour un déterministe naïf. Sur un plan technique, Laplace avait bien remarqué que malgré sa croyance ferme en un ordre déterministe du monde, et malgré des lois physiques qu'il pensait largement connues, certains faits semblaient toujours échapper à la prévision la plus rigoureuse. Il introduit donc dans ses modèles une « fonction d'erreur » permettant de représenter toutes les sources d'imprévu. Par exemple l'erreur humaine dans la mesure ou encore l'imprécision des instruments. Ainsi Laplace a imaginé de décomposer la mesure en une partie prédite par le modèle mathématique juste et une partie attribuable à de l'erreur.

C'est aussi Laplace qui le premier a décrit la distribution en cloche, souvent improprement appelée « Courbe de Gauss ».

C'est lui à qui Napoléon avait signalé « Votre travail est excellent, mais il n'y a pas de trace de Dieu dans votre ouvrage ». À quoi Laplace aurait répondu : « Sire, je n'ai pas eu besoin de cette hypothèse ».

Loin de penser que l'intellect humain était capable des prouesses de son démon éponyme, Laplace s'est intéressé de près à la théorie des probabilités dont il était persuadé qu'elle était la voie permettant de compenser notre ignorance partielle.

« Nous devons donc envisager l'état présent de l'univers comme l'effetde son état antérieur et comme la cause de delui qui va suivre. Une intelligence qui, pour un instant donné, connaîtrait toutes lesforces dont la nature est animée et la situation respective des êtresqui la composent, si d'ailleurs elle était assez vaste pour soumettreces données à l'analyse, embrasserait dans la même formule lesmouvements des plus grands corps de l'univers et ceux du plus légeratome : rien ne serait incertain pour elle, et l'avenir, comme lepassé, serait présent à ses yeux (...).

L'esprit humain offre, dans la perfection qu'il a su donner àl'Astronomie, une faible esquisse de cette intelligence. Sesdécouvertes en Mécanique et en Géometrie, jointes à celles de lapesanteur universelle, l'ont mis à portée de comprendre dans les mêmesexpressions analytiques les états passés et futurs du Système du monde.En appliquant la même méthode à quelques autres objets de sesconnaissances, il est parvenu à ramener à des lois génerales lesphénomènes observés et à prévoir ceux que des circonstances donnéesdoivent fair éclore. Tout ses efforts dans la recherche de la véritétendent à le rapprocher sans cesse de l'intelligence que nous venons deconcevoir, mais dont il restera toujours infiniment éloigné. (...)

La probabilité est relative en partie à cette ignorance, en partie à nos connaissances. (...)

« La théorie des hasards consiste à réduire tous les événements du mêmegenre à un certain nombre de cas également possibles, c'est-à-dire telsque nous soyons également indécis sur leur existence, et à déterminerle nombre de cas favorables à l'événement dont on cherche laprobabilité. Le rapport de ce nombre à celui de tous les cas possiblesest la mesure de cette probabilité, qui n'est ainsi qu'une fractiondont le numérateur est le nombre des cas favorables, et dont ledénominateur est le nombre de tous les cas possibles » .

in Laplace, P.-S., Théorie Analytique des Probabilités, 3rd ed., Paris: Courcier, 1820.

in volume 7 des Oeuvres Complètes,Paris: Gauthier-Villars, 1886. pp. vi-ix.

2. Adolphe Quételet (1796-1874)

Ce mathématicien et astronome belge est considéré comme l'un des fondateurs de la statistique, et le premier à en montrer l'applicabilité aux phénomènes sociaux.

Dans une tentative de fonder une physique sociale, Quételet étudie de façon comparée des données empiriques sur les populations belge et française. Il utilise des représentations graphiques pour résumer les données dans l'espoir de faire émerger des régularités traduisant l'existence de causes sous-jacentes aux phénomènes sociaux.

Le programme de Quételet concernant les statistiques incluait l'idée de fonder la statistique scientifique sur le calcul des probabilités.

Il applique le premier ses idées aux mesures biométriques (taille, poids, ...). Il découvre ainsi que ses données suivent une loi normale (mais qui ne prendra ce nom que plus tard). Il invente le concept actuellement appelé Indice de Masse Corporelle (IMC = taille / poids au carré) qui est très largement utilisé en médecine moderne.

Il invente le concept de l'homme moyen. Ce concept fut controversé. En effet, si l'on considère des variables continues, ce concept peut avoir un sens (on peut dire que l'homme moyen mesure par exemple 1,70m). Mais si l'on considère les caractéristiques discrètes (par exemple le sexe, qui ne prend que deux valeurs, homme ou femme), alors l'individu moyen est quelque chose qui n'est ni homme ni femme... et donc n'existe pas. Plus largement, une critique récurrente, et il faut le reconnaître, parfois fondée, qui pèse sur les sciences humaines utilisant les statistiques tient à ce que l'on peut toujours accuser un résultat calculé sur la base d'une moyenne de n'être qu'une fiction sans contrepartie empirique réelle.

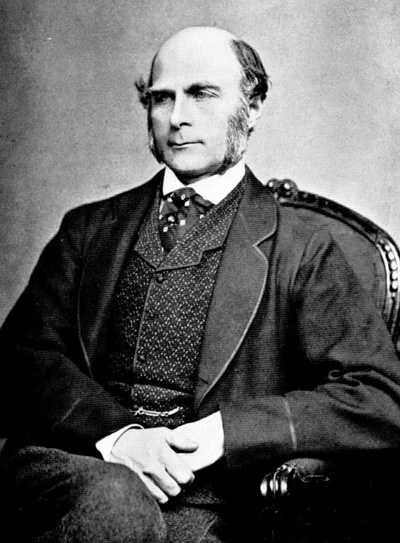

3. Francis Galton (1822-1911)

Esprit plus que brillant qui a su s'appliquer à de multiples problèmes (c'est par exemple lui qui a découvert le caractère unique des empreintes digitales et l'usage qu'on pouvait donc en dériver en criminologie), Francis Galton était le cousin de Charles Darwin.

En 1879, Francis Galton a publié la première définition du terme « psychométrie » : « l'art d'imposer la mesure et le nombre sur les opérations de l'esprit, comme dans la pratique de déterminer les temps de réaction de différentes personnes » (voir plus bas le texte original).

Psychometry, it is hardly necessary to say, means the art of imposing measurement and number upon operations of the mind, as in the practice of determining the reaction-time of different persons. I propose in this memoir to give a new instance of psychometry, and a few of its results. They may not be of any very great novelty or importance, but they are at least definite, and admit of verification; therefore I trust it requires no apology for offering them to the readers of this journal, who will be prepared to agree in the view, that until the phenomena of any branch of knowledge have been subjected to measurement and number, it cannot assume the status and dignity of a science.

Galton a réalisé de nombreux autres travaux intéressants. Il a ainsi découvert le phénomène dit de régression à la moyenne : les enfants de parents très grands tendent à être plus petits que leurs parents, tandis que les parents d'enfants très petits tendent à être plus grands que leurs parents. Ce phénomène s'applique aussi à des variables psychologiques. Ainsi, les parents à bas QI tendent à avoir des enfants à QI plus élevés, tandis que les parents à haut QI tendent à avoir des enfants de QI moins élevé.

Plus important encore, Galton chercha à quantifier la régression à la moyenne, ce qui le mena à élaborer le premier « coefficient de corrélation » qui sera clairement formalisé plus tard par son disciple, Karl Pearson !

D'autres textes originaux de Francis Galton sont téléchargeables sur Galton.org

ou sur le site du Max-Planck Institute : http://vlp.mpiwg-berlin.mpg.de/people/data?id=per78

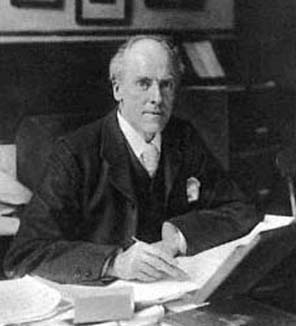

4. Karl Pearson (1857-1936)

Karl Pearson est l'un des auteurs qui a révolutionné les statistiques au début du XXe siècle.

Bien que son nom soit attaché à la formule du coefficient de corrélation linéaire, sa contribution théorique majeure est peut-être d'avoir déplacé le centre d'intérêt de la mesure des nombres vers une notion plus générale, celle de distribution statistique. Ce déplacement conceptuel est majeur, car il reconnaît le caractère intrinsèquement aléatoire de la réalité empirique observée.

Ainsi, selon Pearson, une distribution normale peut être caractérisée par quatre nombres, sa moyenne, sa dispersion (écart-type), son degré de symétrie (à quel point les données sont concentrées ou non d'un seul côté de la moyenne), et l'aplatissement (est-ce que les observations loin de la moyenne ont la fréquence prédite par la loi normale ou non).

Le déplacement conceptuel majeur opéré par Pearson ne tient pas à ces nombres, mais à l'idée que ce qui caractérise une population, ce ne sont pas les nombres eux-mêmes, mais seulement ces quatre paramètres. Autrement dit, pour Pearson, la réalité empirique n'est pas dans les nombres obtenus dans l'échantillon considéré, mais dans les valeurs "réelles" des paramètres que les valeurs mesurées dans l'échantillon permettent d'estimer.

Toutefois, il faudra l'intervention ultérieure d'autres statisticiens de génie, comme Ronald Fischer, pour montrer que les nombres mesurés empiriquement ne peuvent fournir les vraies valeurs des paramètres, mais seulement des estimations imparfaites.

Couleur de fond

Police

Taille de police

Couleur de texte

Crénage de la police

Visibilité de l’image

Espacement des lettres

Hauteur de ligne

Surbrillance de lien

Alignement du texte