Statistique : Tester l'association de variables

Cette grande leçon présente, sous l'angle de la statistique inférentielle, les principales méthodes pour tester l'existence d'une association entre variables : corrélations de variables numériques (r

de Pearson) ordinales (

Cette grande leçon présente, sous l'angle de la statistique inférentielle, les principales méthodes pour tester l'existence d'une association entre variables : corrélations de variables numériques (r

de Pearson) ordinales ( de Spearman,

de Spearman,  de Kendal), ou nominales (

de Kendal), ou nominales ( et

et  ). Après un rappel de la régression linéaire simple, on introduit la corrélation partielle. Finalement, cinq articles sont consacrés à la corrélation multiple.

). Après un rappel de la régression linéaire simple, on introduit la corrélation partielle. Finalement, cinq articles sont consacrés à la corrélation multiple.

1. Tester la liaison entre deux variables

1.3. Comparer deux corrélations dépendantes

Cette section est adaptée à partir d'un article de Steiger (1980) et en reprend les notations.

Il y a trois cas dans lesquels les corrélations à comparer ne sont pas indépendantes et où le traitement s'avère plus complexe :

- lorsque les corrélations ont été obtenues sur les mêmes sujets

- lorsque les corrélations partagent une variable en commun

- lorsque l'on teste la même corrélation à des moments différents

Nous ne traitons ici que du cas n°2 : Nous avons deux corrélations obtenues avec N sujets. Avec Steiger (1980), appelons j la variable commune, h et k les deux autres. Nos corrélations sont rjk et rjh .

1°) Il nous faut évaluer le degré de dépendance entre ces deux corrélations, et cette information nous est fournie par le calcul de la troisième corrélation, rhk. À partir de ce moment, on dispose de trois corrélations.

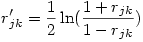

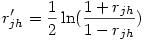

2°) On applique la transformation de Fisher aux deux premières corrélations (rappelons que c’est la fonction arctangente hyperbolique), ce qui donne deux corrélations transformées rjk' et rjh' avec

et

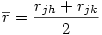

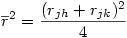

3°) Puisque nous testons l'hypothèse nulle que rjk = rjh, on peut avantageusement remplacer chacune des deux corrélations observées par la moyenne des deux et utiliser cette dernière dans les équations suivantes :

ou encore

4°) On calcule ensuite

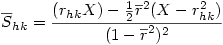

5°) On calcule alors un écart-type groupé Shk

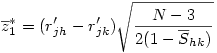

6°) Finalement la variable

suit une loi normale classique qu'il suffit de tester comme toute valeur z.

Couleur de fond

Police

Taille de police

Couleur de texte

Crénage de la police

Visibilité de l’image

Espacement des lettres

Hauteur de ligne

Surbrillance de lien