Statistique inférentielle et psychométrie appliquée

Cette grande leçon introduit la statistique inférentielle et la psychométrie appliquée, ceci dans la perspective de permettre aux étudiants de comprendre les enjeux épistémologiques, scientifiques et techniques de ces matières. Ces enjeux comprennent en particulier la mise au point de méthodes objectives pour l’étude de la variabilité induite expérimentalement ou observée en condition naturelle.

Cette grande leçon introduit la statistique inférentielle et la psychométrie appliquée, ceci dans la perspective de permettre aux étudiants de comprendre les enjeux épistémologiques, scientifiques et techniques de ces matières. Ces enjeux comprennent en particulier la mise au point de méthodes objectives pour l’étude de la variabilité induite expérimentalement ou observée en condition naturelle.

Cette leçon est essentielle pour comprendre les suivantes, car tous les concepts de base de la statistique inférentielle y sont expliqués.

1. Les étapes de la recherche scientifique

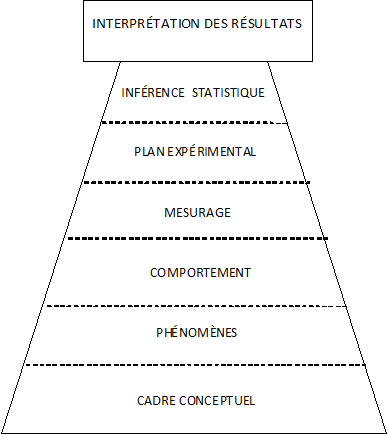

1.2. La pyramide expérimentale

Norman Anderson a proposé « la pyramide expérimentale », un cadre conceptuel général pour décrire le raisonnement scientifique (Anderson, 2001), c'est-à-dire la construction de connaissances générales à partir de données observables. L’idée générale de cette pyramide est que les étapes de l’inférence scientifique constituent un tout dont les différents niveaux sont fondamentalement interdépendants. De ce fait, la validité d’une connaissance dépend de la validité de chacun des niveaux.

Nous allons maintenant détailler les différentes étapes, en montant du bas vers le haut de la pyramide.

Le cadre conceptuel

Un cadre conceptuel est un système de croyances interconnectées. Dans le domaine scientifique, on aime appeler ces croyances des « connaissances ». Ces croyances sont à des niveaux de généralité très divers et peuvent correspondre à de grands débats classiques (nature-culture, inné-acquis, etc.)

Dans toute étude scientifique, le cadre conceptuel est premier. Il peut être très fruste, comme lorsque l’on démarre une recherche sur un sujet qui n’a jamais été étudié, ou au contraire s’appuyer sur des centaines d’années d’élaborations théoriques étayées d’observations empiriques. Mais même dans sa version la plus simple, le cadre conceptuel contient des assomptions sur les phénomènes qu’il est pertinent d’étudier ou non, ou sur les aspects d’un phénomène qu'il serait plus pertinent d’étudier. Par exemple, pendant la période béhavioriste, et pour les chercheurs appartenant à cette mouvance, il n’était pas considéré comme pertinent d’étudier autre chose que des comportements observables. Avec l’arrivée du cognitivisme, les chercheurs en psychologie expérimentale ont réintroduit la possibilité de faire appel, au moins partiellement, aux contenus des données verbales. Le changement de cadre conceptuel se traduit donc par des changements méthodologiques et même, plus profondément, par des changements d'objet d'étude. En fait, le cadre conceptuel peut contenir des croyances sur la totalité des éléments d’une recherche, voire sur la nature même de la recherche en général.

Le phénomène

Un travers de la recherche, lorsque l'on commence l'investigation dans un nouveau domaine, est de confondre ce que l'on observe et ce que l'on cherche à observer. Ainsi, les premiers chercheurs en psychologie, au XIX e siècle, utilisaient l'introspection et tenaient ce que disaient les sujets pour des traces fiables de ce qui se passait dans leur tête. On a fini par s'apercevoir de l'impasse que constituait une perspective aussi naïve et les techniques d'investigation des processus mentaux ont permis de montrer que la représentation qu'un sujet se construit de ses propres processus mentaux, et donc ce qu'il en raconte, peut n'avoir rien à voir avec la réalité de ces processus. Dans la terminologie d’Anderson, le "phénomène" correspond à la chose que l’on cherche à connaître, mais qui, pour toutes sortes de raisons, peut n’être pas directement le comportement que l’on va observer.

Les raisons qui imposent de distinguer le phénomène de la chose à observer incluent notamment les variables parasites, c’est-à-dire des éléments qui viennent perturber le comportement produit par les sujets de sorte qu’en observant le comportement, on n’observe pas le phénomène cible, mais une sorte de mélange du phénomène cible et de la variable perturbatrice. Par exemple, l’expérimentateur qui donne une consigne à un sujet suppose que le comportement résultant traduira le phénomène qu’il étudie. Mais le sujet doit d’abord interpréter la consigne. Des variations dans l’interprétation de la consigne donnée, pour des raisons purement linguistiques par exemple, peuvent conduire à des variations subséquentes du comportement du sujet. Ces variations n’ont rien à voir avec le phénomène étudié par le chercheur.

La couverture du phénomène est aussi affectée par le choix des tâches expérimentales. Certaines peuvent bien cibler un aspect du phénomène mais pas sa totalité, de sorte que les résultats obtenus, même s’ils sont valables, ne se généraliseront pas lorsque la recherche portera sur des tâches légèrement différentes. Certaines tâches expérimentales donnent des résultats qui se généralisent bien, d’autres non.

Les comportements

Dans un cadre expérimental, le comportement du sujet provient d’une interaction entre les caractéristiques propres du sujet et les caractéristiques de la situation construite par l’expérimentateur, et à laquelle le sujet semble avoir accepté de se soumettre.

Sur des études où le chercheur prend le parti d’être moins intrusif, le sujet peut être observé dans une situation qui lui est plus naturelle, c’est-à-dire qui n’a pas été véritablement construite par l’expérimentateur. Bien entendu, il ne s’agit pas d’être naïf et oublier que même dans ces situations, le chercheur a quand même une influence sur les observations, ne serait-ce qu’en choisissant d’observer tel comportement plutôt que tel autre, sous tel angle plutôt que tel autre, etc. De ce fait, l’interprétation ultérieure des données produites devra tenir compte, autant que faire se peut, des choix ayant présidé à l’observation.

Les choix méthodologiques constitutifs de l’observation du comportement font l’objet de controverses scientifiques, car il est toujours possible, face à un résultat dérangeant, de mettre en cause le dispositif de recueil des données plutôt que la théorie testée. D’un autre côté, la théorie sur le fonctionnement de la réalité observée vient déterminer les choix méthodologiques eux-mêmes, de sorte qu’il est quasiment impossible d’obtenir des observations « pures ».

Le mesurage

C’est l'étape cruciale par laquelle des données empiriques observables sont codées numériquement.

Deux concepts sont essentiels pour le mesurage : la validité et la fidélité. La fidélité traduit la capacité de la mesure d’être répliquée. Une mesure porte donc d’autant plus de contenu informationnel qu’elle est fidèle, car les parties de la mesure qui ne se répliquent pas d’une expérience sur l’autre ne sont pas véritablement porteuses d’information. En y regardant de plus près, la notion de fidélité n'est pas équivalente à celle de précision, mais ici, en première approximation, on peut se contenter de garder l'idée générale que ces deux notions à peu près équivalentes : plus une technique de mesurage produit des mesures précises, plus grande sera la fidélité des variables étudiées (voir aussi l'article de L1 sur la

précision des tests). La validité est un concept très complexe qui mériterait plusieurs articles à lui seul (voir par exemple l'article de L1 sur la

validité des tests).

Le plan expérimental

Le plan expérimental a pour premier effet de permettre au chercheur de parler en termes de causalité. En effet, selon le plan expérimental, le chercheur pourra simplement établir des relations entre des variables (observer que telle et telle variables tendent à marcher ensemble) ou au contraire il pourra aller plus loin et parler de causalité, c'est-à-dire qu'il sera en mesure de dire que telle variable CAUSE telle autre. Opérationnellement, cela signifie que si l'on intervient sur les valeurs d'une variable cause, aussi appelée « variable indépendante », il devrait s'ensuivre une modification des valeurs de l'autre variable, la variable effet, dite aussi « variable dépendante ».

Dans une recherche expérimentale, un plan expérimental bien conçu permet aussi de contrôler l'effet de variables parasites que l’on n’a même pas pu identifier.

Au-delà, et d'une manière qui concerne plus directement le contenu de ce cours, le plan expérimental détermine comment les données seront traitées statistiquement. Par suite, il détermine quelle sera la « puissance statistique » du test, c’est-à-dire qu'il détermine la capacité du test à détecter un effet significatif si un tel effet existe réellement.

L’inférence statistique

Ce niveau correspond usuellement à la production de la fameuse valeur « p » qui indique si le test est « significatif » ou non. Malgré son succès dans la communauté scientifique, c’est peut-être le niveau le moins important. Et si l’élément le plus populaire au sein de ce niveau, le test de signification, est certes nécessaire, car il permet de décider si l'on peut considérer les données comme autre chose qu'un pur coup de chance ou de malchance, usuellement, trop d’importance lui est accordée.

L'attrait de cette valeur de signification est tel que des débutants se précipitent très souvent pour rapporter le fait qu'un test est significatif en omettant de rapporter le résultat lui-même : on a un résultat « statistiquement significatif ». Très bien ! Mais... qu'est-ce qui est significatif ? Quel est ce résultat qui est significatif ?

D’autres éléments, auxquels on accorde habituellement moins d’importance, sont en fait plus informatifs. Ainsi en est-il des notions d’intervalles de confiance ou de tailles d’effet.

L’interprétation des résultats

Cela correspond à la partie « discussion » des articles scientifiques et ne fait pas spécifiquement partie de l'objet du présent cours.

3. CONCLUSION

La statistique et le mesurage constituent des moments d'une démarche globale et doivent donc être considérés dans le cadre général de cette démarche, c'est-à-dire que les méthodes employées et la qualité des résultats qu'ils produisent sont toujours à envisager relativement à l'objectif général de la recherche dans laquelle ils prennent place.

Couleur de fond

Police

Taille de police

Couleur de texte