Statistique inférentielle et psychométrie appliquée

| Site: | IRIS - Les cours en ligne de l'UT2J |

| Cours: | UOH / Statistique et Psychométrie en L2 |

| Livre: | Statistique inférentielle et psychométrie appliquée |

| Imprimé par: | Visiteur anonyme |

| Date: | mardi 24 février 2026, 05:16 |

Description

Cette grande leçon introduit la statistique inférentielle et la psychométrie appliquée, ceci dans la perspective de permettre aux étudiants de comprendre les enjeux épistémologiques, scientifiques et techniques de ces matières. Ces enjeux comprennent en particulier la mise au point de méthodes objectives pour l’étude de la variabilité induite expérimentalement ou observée en condition naturelle.

Cette grande leçon introduit la statistique inférentielle et la psychométrie appliquée, ceci dans la perspective de permettre aux étudiants de comprendre les enjeux épistémologiques, scientifiques et techniques de ces matières. Ces enjeux comprennent en particulier la mise au point de méthodes objectives pour l’étude de la variabilité induite expérimentalement ou observée en condition naturelle.

Cette leçon est essentielle pour comprendre les suivantes, car tous les concepts de base de la statistique inférentielle y sont expliqués.

Table des matières

- 1. Les étapes de la recherche scientifique

- 2. Mesurer ou décrire ?

- 3. La prédiction: scientifique ou actuarielle ?

- 4. Mesurage : logique et usage

- 5. Opérationnaliser une grandeur psychologique

- 6. Approche intuitive de la statistique inférentielle

- 7. L'hypothèse nulle

- 8. Population et échantillons

- 9. La décision statistique

- 9.1. On part de l'effet observé

- 9.2. Les causes de l'effet observé: hypothèse expérimentale et hypothèse nulle

- 9.3. Un pari pour ou contre l'hypothèse nulle

- 9.4. Les conséquences potentielles de la décision

- 9.5. Les risques de type I et II

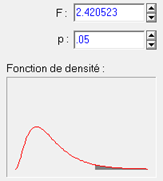

- 9.6. Notion de "valeur-p"

- 9.7. Seuil de signification de la valeur p

- 10. Évaluer la valeur p

- 11. Questionnaire d'auto-évaluation

1. Les étapes de la recherche scientifique

Objectifs.

Replacer statistiques et mesurage dans le contexte général de la recherche.

Prérequis. Cours de L1

Résumé. On examine les étapes de la construction de connaissances générales à partir de données observables. La validité d’une connaissance dépend de la validité de chacune des étapes.

1.1. Le chercheur et le praticien

Le chercheur en sciences humaines, celui qui utilise quotidiennement la statistique et la psychométrie, le fait dans un objectif particulier : élaborer et valider des connaissances générales. Ces connaissances sont éventuellement utilisables ensuite par le praticien mais pas nécessairement. Le chercheur peut avoir un objectif de compréhension pure. Pour le chercheur, le raisonnement statistique est donc un outil conceptuel de première nécessité. Pour autant, la recherche est très loin de se limiter aux statistiques. Il convient donc de replacer la statistique et la psychométrie dans la perspective générale de la démarche de recherche scientifique.

La démarche du chercheur est très différente de celle du praticien qui, souvent, ne s'intéresse aux statistiques qu'en tant qu'aide au diagnostic, au sens où elles peuvent lui fournir des probabilités de pathologies associées à des configurations de symptômes (sachant que le patient a de la fièvre, qu'il tousse, qu'on est en hiver, les chances qu'il ait une grippe sont de ...), ou aide au pronostic (probabilités de guérison associées à des traitements). Mais même le praticien, pour pouvoir utiliser convenablement les statistiques que lui fournissent les chercheurs, doit au minimum comprendre ce que lui disent ces derniers. Il doit donc être capable de comprendre le langage des statistiques, c'est-à-dire savoir construire une représentation mentale valide des concepts véhiculés par le langage statistique.

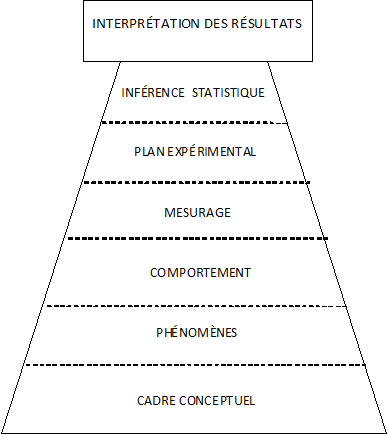

1.2. La pyramide expérimentale

Norman Anderson a proposé « la pyramide expérimentale », un cadre conceptuel général pour décrire le raisonnement scientifique (Anderson, 2001), c'est-à-dire la construction de connaissances générales à partir de données observables. L’idée générale de cette pyramide est que les étapes de l’inférence scientifique constituent un tout dont les différents niveaux sont fondamentalement interdépendants. De ce fait, la validité d’une connaissance dépend de la validité de chacun des niveaux.

Nous allons maintenant détailler les différentes étapes, en montant du bas vers le haut de la pyramide.

Le cadre conceptuel

Un cadre conceptuel est un système de croyances interconnectées. Dans le domaine scientifique, on aime appeler ces croyances des « connaissances ». Ces croyances sont à des niveaux de généralité très divers et peuvent correspondre à de grands débats classiques (nature-culture, inné-acquis, etc.)

Dans toute étude scientifique, le cadre conceptuel est premier. Il peut être très fruste, comme lorsque l’on démarre une recherche sur un sujet qui n’a jamais été étudié, ou au contraire s’appuyer sur des centaines d’années d’élaborations théoriques étayées d’observations empiriques. Mais même dans sa version la plus simple, le cadre conceptuel contient des assomptions sur les phénomènes qu’il est pertinent d’étudier ou non, ou sur les aspects d’un phénomène qu'il serait plus pertinent d’étudier. Par exemple, pendant la période béhavioriste, et pour les chercheurs appartenant à cette mouvance, il n’était pas considéré comme pertinent d’étudier autre chose que des comportements observables. Avec l’arrivée du cognitivisme, les chercheurs en psychologie expérimentale ont réintroduit la possibilité de faire appel, au moins partiellement, aux contenus des données verbales. Le changement de cadre conceptuel se traduit donc par des changements méthodologiques et même, plus profondément, par des changements d'objet d'étude. En fait, le cadre conceptuel peut contenir des croyances sur la totalité des éléments d’une recherche, voire sur la nature même de la recherche en général.

Le phénomène

Un travers de la recherche, lorsque l'on commence l'investigation dans un nouveau domaine, est de confondre ce que l'on observe et ce que l'on cherche à observer. Ainsi, les premiers chercheurs en psychologie, au XIX e siècle, utilisaient l'introspection et tenaient ce que disaient les sujets pour des traces fiables de ce qui se passait dans leur tête. On a fini par s'apercevoir de l'impasse que constituait une perspective aussi naïve et les techniques d'investigation des processus mentaux ont permis de montrer que la représentation qu'un sujet se construit de ses propres processus mentaux, et donc ce qu'il en raconte, peut n'avoir rien à voir avec la réalité de ces processus. Dans la terminologie d’Anderson, le "phénomène" correspond à la chose que l’on cherche à connaître, mais qui, pour toutes sortes de raisons, peut n’être pas directement le comportement que l’on va observer.

Les raisons qui imposent de distinguer le phénomène de la chose à observer incluent notamment les variables parasites, c’est-à-dire des éléments qui viennent perturber le comportement produit par les sujets de sorte qu’en observant le comportement, on n’observe pas le phénomène cible, mais une sorte de mélange du phénomène cible et de la variable perturbatrice. Par exemple, l’expérimentateur qui donne une consigne à un sujet suppose que le comportement résultant traduira le phénomène qu’il étudie. Mais le sujet doit d’abord interpréter la consigne. Des variations dans l’interprétation de la consigne donnée, pour des raisons purement linguistiques par exemple, peuvent conduire à des variations subséquentes du comportement du sujet. Ces variations n’ont rien à voir avec le phénomène étudié par le chercheur.

La couverture du phénomène est aussi affectée par le choix des tâches expérimentales. Certaines peuvent bien cibler un aspect du phénomène mais pas sa totalité, de sorte que les résultats obtenus, même s’ils sont valables, ne se généraliseront pas lorsque la recherche portera sur des tâches légèrement différentes. Certaines tâches expérimentales donnent des résultats qui se généralisent bien, d’autres non.

Les comportements

Dans un cadre expérimental, le comportement du sujet provient d’une interaction entre les caractéristiques propres du sujet et les caractéristiques de la situation construite par l’expérimentateur, et à laquelle le sujet semble avoir accepté de se soumettre.

Sur des études où le chercheur prend le parti d’être moins intrusif, le sujet peut être observé dans une situation qui lui est plus naturelle, c’est-à-dire qui n’a pas été véritablement construite par l’expérimentateur. Bien entendu, il ne s’agit pas d’être naïf et oublier que même dans ces situations, le chercheur a quand même une influence sur les observations, ne serait-ce qu’en choisissant d’observer tel comportement plutôt que tel autre, sous tel angle plutôt que tel autre, etc. De ce fait, l’interprétation ultérieure des données produites devra tenir compte, autant que faire se peut, des choix ayant présidé à l’observation.

Les choix méthodologiques constitutifs de l’observation du comportement font l’objet de controverses scientifiques, car il est toujours possible, face à un résultat dérangeant, de mettre en cause le dispositif de recueil des données plutôt que la théorie testée. D’un autre côté, la théorie sur le fonctionnement de la réalité observée vient déterminer les choix méthodologiques eux-mêmes, de sorte qu’il est quasiment impossible d’obtenir des observations « pures ».

Le mesurage

C’est l'étape cruciale par laquelle des données empiriques observables sont codées numériquement.

Deux concepts sont essentiels pour le mesurage : la validité et la fidélité. La fidélité traduit la capacité de la mesure d’être répliquée. Une mesure porte donc d’autant plus de contenu informationnel qu’elle est fidèle, car les parties de la mesure qui ne se répliquent pas d’une expérience sur l’autre ne sont pas véritablement porteuses d’information. En y regardant de plus près, la notion de fidélité n'est pas équivalente à celle de précision, mais ici, en première approximation, on peut se contenter de garder l'idée générale que ces deux notions à peu près équivalentes : plus une technique de mesurage produit des mesures précises, plus grande sera la fidélité des variables étudiées (voir aussi l'article de L1 sur la

précision des tests). La validité est un concept très complexe qui mériterait plusieurs articles à lui seul (voir par exemple l'article de L1 sur la

validité des tests).

Le plan expérimental

Le plan expérimental a pour premier effet de permettre au chercheur de parler en termes de causalité. En effet, selon le plan expérimental, le chercheur pourra simplement établir des relations entre des variables (observer que telle et telle variables tendent à marcher ensemble) ou au contraire il pourra aller plus loin et parler de causalité, c'est-à-dire qu'il sera en mesure de dire que telle variable CAUSE telle autre. Opérationnellement, cela signifie que si l'on intervient sur les valeurs d'une variable cause, aussi appelée « variable indépendante », il devrait s'ensuivre une modification des valeurs de l'autre variable, la variable effet, dite aussi « variable dépendante ».

Dans une recherche expérimentale, un plan expérimental bien conçu permet aussi de contrôler l'effet de variables parasites que l’on n’a même pas pu identifier.

Au-delà, et d'une manière qui concerne plus directement le contenu de ce cours, le plan expérimental détermine comment les données seront traitées statistiquement. Par suite, il détermine quelle sera la « puissance statistique » du test, c’est-à-dire qu'il détermine la capacité du test à détecter un effet significatif si un tel effet existe réellement.

L’inférence statistique

Ce niveau correspond usuellement à la production de la fameuse valeur « p » qui indique si le test est « significatif » ou non. Malgré son succès dans la communauté scientifique, c’est peut-être le niveau le moins important. Et si l’élément le plus populaire au sein de ce niveau, le test de signification, est certes nécessaire, car il permet de décider si l'on peut considérer les données comme autre chose qu'un pur coup de chance ou de malchance, usuellement, trop d’importance lui est accordée.

L'attrait de cette valeur de signification est tel que des débutants se précipitent très souvent pour rapporter le fait qu'un test est significatif en omettant de rapporter le résultat lui-même : on a un résultat « statistiquement significatif ». Très bien ! Mais... qu'est-ce qui est significatif ? Quel est ce résultat qui est significatif ?

D’autres éléments, auxquels on accorde habituellement moins d’importance, sont en fait plus informatifs. Ainsi en est-il des notions d’intervalles de confiance ou de tailles d’effet.

L’interprétation des résultats

Cela correspond à la partie « discussion » des articles scientifiques et ne fait pas spécifiquement partie de l'objet du présent cours.

3. CONCLUSION

La statistique et le mesurage constituent des moments d'une démarche globale et doivent donc être considérés dans le cadre général de cette démarche, c'est-à-dire que les méthodes employées et la qualité des résultats qu'ils produisent sont toujours à envisager relativement à l'objectif général de la recherche dans laquelle ils prennent place.

2. Mesurer ou décrire ?

Objectifs. Introduire la problématique du mesurage en psychologie comme cas particulier de la description scientifique.

Prérequis. Aucun.

Résumé. La psychologie sera une discipline scientifique générale si ses connaissances sont objectives et générales. L'objectivité est définie selon un critère d'interchangeabilité des observateurs lorsqu'ils décrivent un phénomène particulier. Lorsque la description prend la forme d'un nombre ou d'un intervalle de nombres, c'est que le phénomène est conçu, implicitement ou explicitement, comme un phénomène ordinal ou quantitatif.

2.1. L'objectivité des descriptions psychologiques

Dans la mesure où la psychologie aspire à être une science empirique, c'est-à-dire une science des êtres réels dotés d'une psychologie, son problème préliminaire consiste à décrire les êtres du point de vue auquel elle s'intéresse. En effet, une psychologie qui admettrait d'entrée de jeu que les phénomènes psychologiques sont indescriptibles se condamnerait à être une science mort-née. La constitution d'un domaine de description des êtres psychologiques (i.e., dotés d'une psychologie) présente plusieurs problèmes, à commencer par celui de l' objectivité de ses descriptions.

Savoir si une description est objective est une question épineuse. Si je dis que Paul est très intelligent par exemple, on peut se demander si Paul est réellement très intelligent, c'est-à-dire mettre en doute la correspondance entre ce qu'énonce ma description et l'intelligence de Paul. Ou bien j'admets que l'intelligence très élevée de Paul existe indépendamment de l'appréhension que je peux en avoir, auquel cas l'intelligence de Paul est postulée comme un phénomène qui a sa propre ontologie (ou encore sa propre existence), ou bien je considère que l'intelligence de Paul est essentiellement le résultat de mon regard sur Paul, c'est-à-dire que si personne ne s'intéresse à Paul, son intelligence n'existe pas. Dans le premier cas, l'intelligence de Paul est une propriété psychologique à laquelle on attribue une ontologie intrinsèque, tandis que dans le second cas, l'intelligence de Paul consiste en un jugement qui confère à Paul le statut social de quelqu'un qui possède un certain nombre de capacités, indépendamment de ce que Paul peut effectivement faire. Et ce jugement peut être objectif ou subjectif. Il est subjectif s'il dépend de moi, en ce sens que Brigitte ne trouve pas que Paul est très intelligent. Il est objectif si Brigitte et n'importe qui d'autre, y compris Paul, trouve que Paul est très intelligent. Cette réflexion préliminaire est inspirée par l'ouvrage de John R. Searle qui s'intitule The construction of social reality.

Cette analyse met en évidence que la question de l'objectivité des descriptions psychologiques comporte au moins deux problèmes :

- le problème ontologique (l'intelligence de Paul a-t-elle une existence propre ?),

- le problème de l'objectivité épistémique (l'intelligence de Paul est-elle une propriété qui peut être attestée publiquement ?).

Il se peut que les tests psychologiques soient un moyen de décrire avec objectivité (épistémique) des réalités construites socialement, c'est-à-dire qui n'ont pas d'autre ontologie que celle que leur confère une communauté sociale. La psychologie est une discipline éminemment ambigüe quant à ses objectifs : s'agit-il de déterminer des individus dans une grille essentiellement fonctionnelle en fonction des besoins pragmatiques des situations (recrutement, soins, qualification, etc.), ou bien d'identifier des contraintes (lois) régissant le cours de phénomènes psychologiques possédant leur propre ontologie ?

Il demeure que je suis un juge, c'est-à-dire que ma proposition descriptive, "Paul est très intelligent", engage mes capacités sensibles et intellectuelles vis-à-vis de la communauté des êtres qui parlent le langage descriptif que j'utilise. Pour évaluer l'objectivité de mon jugement, la seule chose que je peux faire est de recourir au témoignage des autres concernant l'intelligence de Paul, ne serait-ce qu'en pensée. Il ne s'agit pas d'objectivité au sens de la postulation de l'ontologie d'une propriété intrinsèque, mais d'objectivité au sens de l'interchangeabilité des juges (objectivité épistémique). Que plusieurs juges s'accordent exactement sur l'état psychologique d'un être étant donnés l'expérience (intime) qu'ils en ont et un certain langage de description qu'ils partagent n'est pas un fait trivial : c'est que ce langage est capable de déterminer quelque chose de l'être qu'il s'agit de décrire, de telle manière que je pourrai faire confiance à n'importe quel témoin, puisque ce témoin fonctionne comme moi-même quand il fait l'expérience de l'être auquel je m'intéresse, et que n'importe qui pourra aussi me faire confiance si je suis le témoin de cet être, puisque je fonctionne comme lui-même.

Si nous sommes trois à avoir rencontré Paul aujourd'hui, nous pouvons séparément répondre à la question suivante :

Paul est très intelligent :

- vrai

- faux

- je ne sais pas.

La solution que nous proposons pour établir non pas la réalité de la description, mais son objectivité épistémique, est la suivante : il suffit de l'unanimité sur "vrai" d'un comité de juges qualifiés, c'est-à-dire, ici, de personnes (i) parlant le même langage descriptif, (ii) ayant rencontré Paul aujourd'hui, ou vu un enregistrement de Paul aujourd'hui. Faute d'accès à l'état réel de Paul, on utilise l'unanimité quant à la vérité d'une proposition comme forme spéciale d'intersubjectivité. Le jugement de vérité ne porte pas sur l'état réel de Paul. Il s'appuie sur l'expérience subjective de l'état de Paul par des êtres faillibles et limités, dont on utilise les capacités cognitives à juger de la vérité de la proposition descriptive. Ce qui est vrai ou faux n'est pas un état réel, mais une description intersubjective.

La vérité d'une description n'est pas absolue, puisqu'elle dépend du comité (réel et en pratique imaginaire) dont on invoque la belle unanimité. L'objectivité scientifique d'une proposition descriptive signifie que sa valeur de vérité dépend non spécifiquement de celui qui l'énonce, le juge étant par principe interchangeable avec n'importe quel autre juge. Les descriptions objectives correspondent à ce que Popper, dans La logique de la découverte scientifique, appelle des "propositions ou énoncés de base" ("basic statements").

Une fois qu'on s'est mis d'accord sur l'objectivité des descriptions psychologiques, c'est-à-dire qu'on a convenu de ce qu'une description est objective si on peut montrer qu'un jury quelconque est unanime sur sa vérité, on dispose d'un critère pour valider un langage descriptif : un langage descriptif est un langage qui permet des descriptions objectives. Le problème qui surgit immédiatement est qu'un adjectif comme "intelligent" ne permet pas de description objective. En effet, il sera difficile à quiconque dans un tel comité de ne jamais utiliser l'option de réponse "je ne sais pas" ; ce type d'expérience conduite dans un amphithéâtre de psychologie montre facilement qu'il existe de nombreuses situations de non-unanimité. Nous touchons ici un point conflictuel en psychologie. Par exemple, les psychologues qui utilisent les tests projectifs, ou les descriptions du DSM par exemple, ne sont pas intransigeants quant à l'objectivité des descriptions afférentes à ces cadres descriptifs. Si les descriptions dépendent spécifiquement des juges, le processus d'objectivation produit une variabilité nuisible à la connaissance scientifique des êtres psychologiques, puisque cette variété ne dépend par principe pas des êtres décrits, mais des êtres descripteurs. À nos yeux, ce problème n'est pas convenablement réglé dans de nombreux champs de la psychologie.

2.2. Décrire pour chercher des faits généraux

L'application du critère de l'objectivité des descriptions a une conséquence constitutive : la description littéraire d'un être psychologique n'est pas une description scientifique parce qu'elle n'est pas objective. Prenons par exemple la description d'Emma Bovary par Flaubert : eh bien la psychologie scientifique doit s'en passer, malgré sa richesse, sa profondeur, bref, malgré la merveilleuse véridicité à laquelle elle nous permet d'accéder. La description littéraire n'entre pas dans le projet de la connaissance scientifique parce que ce qui est visé est une connaissance générale des êtres psychologiques (cf. l'article Les étapes de la recherche scientifique). Plus précisément, il s'agit de dégager de l'infinie variation des cas particuliers des phénomènes généraux, autrement dit des lois empiriques.

Une loi empirique repose sur une structure descriptive simple : d'un côté, on décrit les êtres psychologiques d'après un ensemble d'états initiaux possibles (actualisés ou non actualisés), et un ensemble d'états dont l'actualisation dépend par hypothèse de celle des premiers. Par exemple, on demande à un adulte quelconque de lire à voix haute une liste de 20 mots et, dès qu'il a terminé, de dire quels sont les mots dont il se souvient. Par construction, l'état initial de cet adulte est "a lu les 20 mots" (par opposition a "n'a pas lu les 20 mots"). L'état "final" est "a rappelé les 20 mots" ou "n'a pas rappelé les 20 mots". La loi empirique peut se formuler de la manière suivante :

Quel que soit un adulte, s'il a lu les 20 mots il ne rappellera pas les 20 mots (sans aide extérieure).

BIen entendu, cette loi peut être fausse. Toutes les lois empiriques peuvent être fausses. Des observations générales analogues conduisent à l'idée que la mémoire immédiate est limitée, d'où la recherche d'explications. Autrement dit, la description scientifique n'a pas de finalité artistique. C'est une description orientée par la recherche de faits généraux, qui deviendront ensuite des faits à expliquer, qui conduiront peut-être à de nouvelles observations tirant leur sens de ces tentatives d'explication.

Lorsqu'un fait général est corroboré de nombreuses fois, on finit par s'y habituer. Par exemple, vous vous tenez debout et vous lâchez par inadvertance votre tasse de café fumant. Votre tasse se tient bien tranquillement dans la position spatiale où vous l'avez lâchée, alors que l'habitude vient de vous faire sauter en arrière pour éviter les éclaboussures. Un physicien qui montre qu'il est possible de lâcher son café dans ces conditions aura sans doute beaucoup de facilité à trouver un poste, parce qu'il vient de découvrir que la gravité n'est pas aussi générale que ce qu'on croyait. Il aura découvert des conditions pour lesquelles cette loi ne s'applique pas. En psychologie, les descriptions objectives sont en principe intéressantes si elles falsifient des faits généraux bien admis. Par exemple, le psychologue qui parvient à former n'importe quel adulte à se rappeler les 20 mots de la liste se trouverait dans des conditions analogues à celles de notre physicien pour obtenir un poste ou des financements. (Un de nos collègues a récemment attiré notre attention sur l'hypermnésie : il paraît qu'il existe des gens capables de se rappeler une liste de 20 mots dans les conditions expérimentales que nous avons décrites plus haut : comment font-ils ?)

Il faut décrire objectivement pour qu'il soit possible de découvrir ou d'énoncer des faits généraux. Il faut des faits généraux pour qu'il soit possible de découvrir ou d'énoncer des faits singuliers qui les dénoncent, et qui stimuleront la recherche d'explications, c'est-à-dire la recherche des conditions spéciales qui autorisent ce que la loi interdit -- la loi étant la généralisation du fait général, notamment au futur.

2.3. Mesurer c'est décrire une grandeur

Dans ce qui précède, nous n'avons pas eu besoin d'identifier la description à la quantification. Pourtant, en psychologie, on accorde une grande importance à la quantification, pour des raisons complexes. Nous ne prétendrons pas analyser ici ces raisons, mais nous pointerons une interprétation possible : la plupart des grandeurs qui intéressent les psychologues sont des métaphores du langage de la vie quotidienne. Par exemple, on parle de la capacité de la mémoire immédiate comme d'une grandeur : il y a des gens plus ou moins capables, donc il s'agit de mesurer cette capacité. Ce type de démarche s'oppose à une démarche qui part du principe que c'est une question empirique (et non de droit) de savoir si l'idée d'une grandeur latente, i.e., non observable, correspond à une réalité dont l'ontologie est intrinsèque. Les psychologues ont l'habitude de considérer qu'il est normal de mesurer des grandeurs non empiriques par des procédés numérologiques (cf. l'article "Score psychométrique" de L1) et nous ne partageons pas cette position parce qu'elle n'est pas justifiable dans une perspective réaliste (i.e., dans une perspective qui assigne comme but à la recherche scientifique la connaissance de la réalité telle qu'elle existe indépendamment du sujet de la connaissance, par opposition à des productions linguistiques partagées -- dont Searle nous montre qu'il faut bien, par ailleurs, reconnaître l'ontologie sociale ou encore subjective).

Par définition, ce qui est mesurable est une grandeur ; les grandeurs physiques sont des concepts fondés sur des réseaux de connaissances empiriques complexes. Un ampèremètre mesure l'intensité dans un circuit électrique, pas seulement parce que nous souhaitons collectivement que l'intensité soit mesurée, mais en vertu de la capacité de l'instrument à résumer les faits empiriques généraux qui permettent de définir l'intensité du courant électrique comme une grandeur. Ceci ne signifie pas qu'il faille s'interdire d'utiliser des métaphores si on fait de la recherche scientifique, mais qu'il faut s'interdire de prendre ces métaphores pour des propriétés intrinsèques (réification). Nous renvoyons le lecteur au chapitre plus bas "Opérationnaliser une grandeur psychologique ".

2.4. Bricolages psychotechniques pour décideurs dans le brouillard

La psychologie s'est développée sous un régime historique particulier : avant même qu'elle n'atteigne sa maturité, il a fallu qu'elle rende service. D'où l'immense développement des méthodes psychotechniques, qui reposent pour l'essentiel sur une procédure d'observation standardisée couplée à une règle de projection des observations sur une échelle de scores. C'est ainsi que les psychologues ont pris l'habitude d'utiliser les tests psychologiques pour étayer des décisions incertaines. Nous renvoyons le lecteur à l'article "Applications de la psychométrie" pour un aperçu. Le fait d'éduquer systématiquement les psychologues à manipuler des scores a un corollaire : ils sont systématiquement éduqués à ne pas réfléchir à la manière dont on construit les descriptions qui sont nécessaires à la numérologie psychométrique - c'est-à-dire la fabrication de scores à partir d'étiquettes numériques codant des réponses qualitatives (voir l'article de L1 "Score psychométrique"). L'article "Algèbre d'événements" aborde ce point en détail.

L'article suivant développe le problème de la prédiction scientifique, dont la maîtrise est un préalable à la maîtrise des techniques inductives qui utilisent les scores psychométriques comme support d'inférence.

3. La prédiction: scientifique ou actuarielle ?

Objectifs . Poser le problème de la prédiction scientifique.

Prérequis. Aucun.

Résumé. La prévision est présentée selon deux perspectives : soit on dispose de règles générales, auquel cas il s'agit de prévision scientifique parce que ces règles sont falsifiables par chaque prévision, soit on ne dispose pas de règles générales et on peut alors s'appuyer sur l'hypothèse que les phénomènes auxquels on s'intéresse obéissent à une loi de probabilité. Mais alors la prévision d'un événement singulier n'a pas de fondement, et on peut seulement espérer en tirer profit en termes de multitudes de prédictions.

3.1. Le problème

Prédire un comportement consiste à se projeter dans le futur, c'est-à-dire à s'aventurer dans l'inconnu armé de conjectures. Il y a des conjectures qui, a posteriori, s'avèrent fondées, d'autres non, et d'autres qui ne peuvent pas être vérifiées (par exemple, il est probable que vous rencontriez l'amour de votre vie demain). La prévision scientifique est un art de la divination qui se fonde sur l'exigence de falsifiabilité de ses prévisions, et l'élimination des croyances qui s'avèrent fausses précisément parce qu'elles ont conduit à de fausses prévisions.

La notion de falsifiabilité demande quelques explications. Par exemple, prédire que "demain le ciel sera sans nuage" est une prédiction falsifiable : soit il n'y aura pas de nuage, auquel cas la proposition sera vérifiée, soit il y aura au moins un nuage, auquel cas la proposition sera falsifiée. Mais énoncer qu'il y a 9 chances sur 10 que le ciel soit sans nuage demain n'est pas une proposition scientifique parce qu'elle est tautologique : elle implique logiquement que, soit il y aura au moins un nuage, soit il n'y en aura pas. Le recours à la probabilité d'un événement singulier se fonde sur des modèles peut-être scientifiques (i.e., falsifiables, et alors, il s'agit de préciser en quoi ils sont falsifiables en jugeant sur pièces), mais cela ne suffit pas pour faire de ce type d'énoncés des énoncés scientifiques.

La notion de prédiction scientifique est très clairement définie par Popper (1973) : "Pour prévoir, il est besoin de lois et de conditions initiales ; si l'on ne dispose pas de lois ou si l'on ne peut constater de conditions initiales, il ne s'agit plus de prévisions scientifiques" (p. 207). Dans l'article précédent, nous avons développé la notion de fait général (voir aussi Vautier, 2011 en VF). Dans ce qui suit, nous présentons de manière critique l'approche actuarielle de la prévision.

3.2. Prévision actuarielle d'un événement singulier

La prévision actuarielle consiste à utiliser la fréquence des événements pour une prévision probabiliste (i.e., infalsifiable par l'observation de l'événement en question, mais testable en théorie sur une série de prévisions). Nous allons utiliser un exemple proposé par Lee J. Cronbach dans son ouvrage intitulé "Essentials of psychological testing" (1990, voir aussi notre article du cours de L1 "Un test psychométrique est-il valide ?").

Cronbach utilise les données suivantes :

| D | C |

B

|

A

|

|

|

41-50

|

99

|

92

|

62

|

21

|

| 31-40 |

98

|

82

|

42

|

10

|

|

21-30

|

94

|

66

|

25

|

4

|

|

11-20

|

85

|

47

|

12

|

1 |

|

1-10

|

71

|

29

|

5

|

<1

|

Les intervalles de valeurs de la première colonne indiquent la somme des scores obtenus à deux tests d'aptitude (raisonnement arithmétique, perception spatiale). Les scores proviennent de lycéens inscrits dans 25 lycées (les données sont en fait empruntées à une étude plus ancienne et les détails ne sont pas communiqués). Les lettres A à D indiquent des grades, c'est-à-dire des niveaux d'évaluation en dessin industriel (notre traduction de "drafting") : le meilleur grade est le grade A.

Les nombres contenus dans les cellules sont des pourcentages cumulés : par exemple, parmi les lycéens ayant un score compris entre 41 et 50 points, 21% ont obtenu le grade A, 62% ont obtenu au moins le grade B, 92% ont obtenu au moins le grade C, etc.

Cronbach évoque un conseiller qui devrait diriger l'attention du lycéen qu'il conseille, et qui a obtenu 25 points, sur la ligne de la table indiquant "qu'il a deux chances sur trois d'obtenir au moins le grade C" (p. 153). Que signifie cette proposition ? D'un point de vue factuel, 66% des lycéens de l'échantillon qui ont obtenu un score compris entre 21 et 30 points ont au moins le grade C. Il s'agit d'une fréquence conditionnelle. L'interprétation que Cronbach suggère au conseiller de suggérer au lycéen qui est venu le consulter n'est pas la même. Elle repose sur la notion de chance d'obtenir au moins le grade C.

La notion selon laquelle un événement a une chance parmi n ( n étant un nombre naturel non nul) de se réaliser est une notion obscure sinon obscurantiste. Il s'agit d'invoquer le hasard, ou encore une force occulte qui régirait le cours des événements. Ce que nous savons logiquement est (i) qu'il existe une possibilité sur deux pour que l'événement se réalise, et (ii) que nous ignorons si cet événement se réalisera. En fait, l'interprétation probabiliste de Cronbach est un aveu d'ignorance du conseiller. Mais alors, à quoi sert le conseiller ?

Le conseiller a deux choix : soit il se drape dans le rôle de divinateur savant (parce que l'actuariat, c'est une affaire de savants), soit il refuse d'endosser ce rôle. Si le lycéen cherche un gourou, le premier choix correspond à une logique de satisfaction de la demande. Si, de surcroît, le conseiller est payé pour faire de la satisfaction, son choix est rationnel, parce que s'il produit de l'insatisfaction il sera rapidement remercié par l'institution qui l'emploie, pourvu que ladite institution dispose des moyens juridiques de définir l'insatisfaction des clients comme une faute professionnelle. Si le lycéen cherche de l'information, alors le second choix est approprié et il n'est pas nécessaire d'utiliser le langage de la prédiction d'un événement futur.

L'obtention du grade "au moins C" dépend de toutes sortes de circonstances qui échappent à la façon dont Cronbach envisage le conseil dans le paragraphe qui nous intéresse. Le lycéen peut apprendre des données que parmi les lycéens de sa catégorie (i.e., ceux qui ont obtenu un score compris entre 21 et 30 points), tout est possible en matière de grade. Il peut donc supposer que présentement, rien ne l'empêche d'obtenir tout grade. En fait, les données indiquent que le score psychotechnique ne permet pas de faire l'hypothèse qu'il existe des scores interdisant l'obtention de n'importe quel grade ; en d'autres termes, les données ne révèlent aucun fait général. Il est alors tentant d'en déduire que la connaissance du score aux tests ne sert à rien : le conseiller pourrait indiquer à un lycéen inquiet parce qu'il a obtenu un score très faible que rien dans les données dont il dispose ne permet d'exclure qu'il pourrait obtenir le meilleur grade. Quant à la question de savoir ce qui déterminerait l'obtention d'un grade particulier, les données ne sont pas pertinentes.

3.3. Prévision actuarielle d'un événement collectif

La prévision actuarielle n'est pas destinée à la prévision d'événements singuliers, mais à la prévision d'événements collectifs. Un événement collectif réfère à une classe d'événements, ou encore, et peut-être plus exactement, à une classe de référence. Continuons avec l'exemple de Cronbach, en procédant en deux temps : d'abord de manière rétrospective, puis de manière prospective.

Si on considère les lycéens qui ont obtenu un score entre 41 et 50 points par exemple, quel est le pourcentage conditionnel (i.e., conditionnellement à la classe [41, 50]) de chaque grade ?

- 21% pour le grade A,

- 62 - 21 = 41% pour le grade B,

- 92 - 62 = 30% pour le grade C,

- 99 - 92 = 7% pour le grade D,

ce qui donne un total de 99% logiquement impossible. Les erreurs d'arrondi expliquent peut-être cette bizarrerie et nous considérerons que 8% des étudiants de cette classe ont le grade D.

Maintenant, expérimentons. On tire au sort un des lycéens de la classe et on note son grade dans le tableau suivant :

|

Tirage

|

A | B |

C

|

D

|

| 1 |

0

|

0

|

1

|

0

|

|

2

|

0

|

0

|

0

|

1

|

|

3

|

0

|

0

|

0

|

1

|

|

...

|

|

|

||

|

n

|

|

|

|

|

On obtient un lycéen qui a le grade C. On repose le nom de ce lycéen dans son urne et on recommence, pour obtenir cette fois un lycéen de type D. On repose le nom de ce lycéen et on recommence, avec le même résultat. On peut recommencer nos observations jusqu'à en avoir, par exemple, n = 2000.

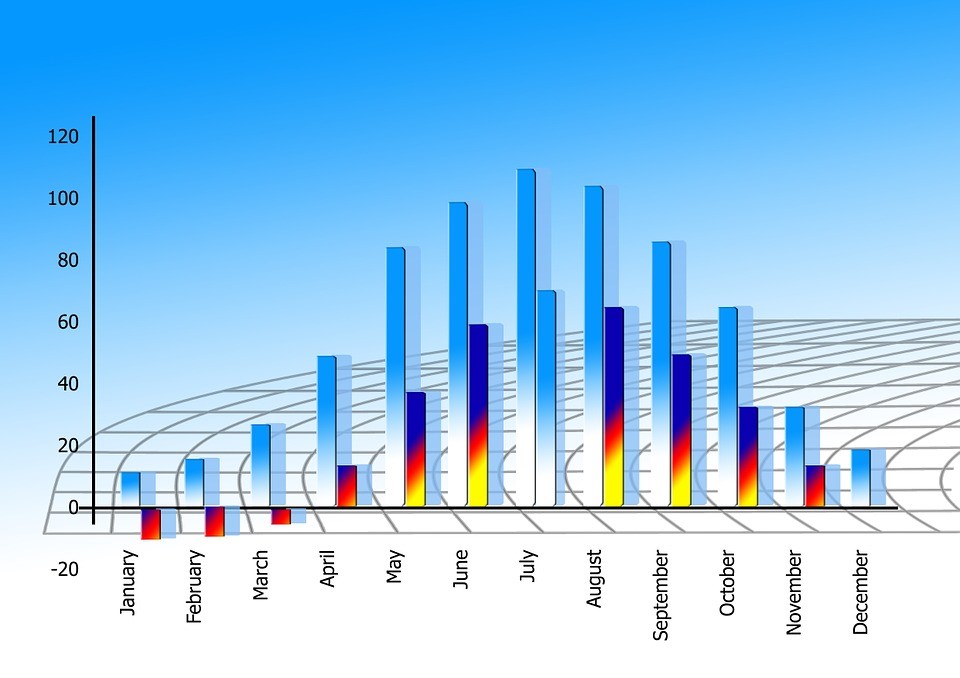

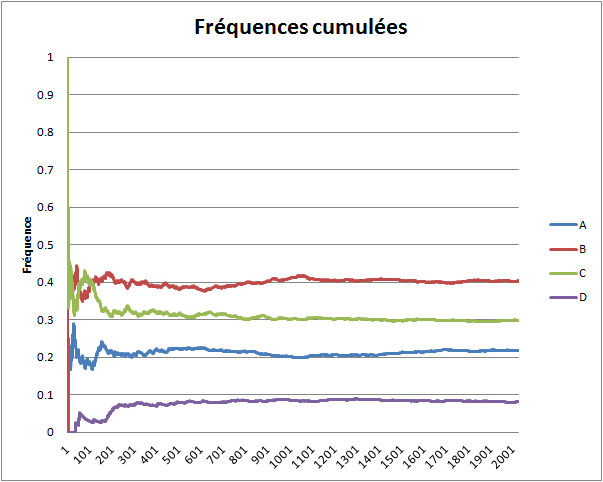

On calcule alors la fréquence de chaque événement (A, B, C ou D) lorsqu'on a fait un tirage, deux tirages, trois tirages, etc. jusqu'à n tirages, et on affiche les résultats sur le graphique ci-dessous.

Le phénomène remarquable est la convergence de chaque série de fréquences. La série des fréquences de l'événement A converge vers la valeur de la probabilité de l'événement A, la série des fréquences de l'événement B converge vers la valeur de la probabilité de B, etc. Si on recommence toute l'expérience, on obtiendra des courbes (très probablement) différentes, mais ces courbes convergeront encore vers la valeur de la probabilité de l'événement auquel elles sont associées. Pour expérimenter par vous-mêmes à l'aide d'un simulateur informatique, cliquez ici. La théorie des probabilités explique logiquement cette nécessité.

Maintenant, tournons-nous vers l'utilisation prospective des données. En effet, les résultats que nous venons d'expliquer reposent sur la donnée de l'échantillon des lycéens, qui permet de connaître la proportion de chaque événement sur laquelle se fonde la convergence. La prévision actuarielle d'un phénomène porte sur la fréquence dudit phénomène (ou événement) -- c'est pourquoi nous parlons d'événement collectif -- et s'applique à des événements futurs. Le problème qui se pose est de savoir si la fréquence converge. Question purement métaphysique, puisqu'on ne connaît pas ladite population et donc pas la proportion des événements.

On décide alors de croire en la convergence. Muni de cette hypothèse, on peut supposer que la fréquence de A dans des échantillons de nouveaux lycéens qui ont un score entre 41 et 50 points tend vers une certaine valeur, pas forcément voisine de .21, au fur et à mesure qu'on augmente la taille de ces échantillons. Si je dois optimiser le nombre de fois où j'ai raison en prédisant un grade, je peux donc prévoir systématiquement le grade B compte tenu de ce que je connais, pourvu que j'aie affaire à un grand nombre de décisions (regardez sur les courbes combien d'observation sont nécessaires pour que les courbes ne se croisent plus). S'il s'avérait que les courbes de fréquences de très gros échantillons ne soient pas convergentes, il faudrait en déduire que le recours à la notion de loi de probabilité (i.e., l'idée que les proportions dans la population sont fixes) n'est pas fondé.

Ce type de raisonnement est utilisé par les assurances qui ajustent leurs tarifs en fonction des types de clients. Par exemple, on peut s'intéresser à la fréquence des accidents de la route en fonction du sexe et de l'âge des conducteurs, pour appliquer des tarifs avantageux aux clients appartenant aux classes les plus sûres si ces clients ne veulent pas être solidaires des clients des classes les moins sûres (ici, le lecteur aura compris que nous ne connaissons pas grand-chose en matière de politique tarifaire des assurances).

3.4. Conclusion

La notion de prévision est polysémique. Nous avons distingué la prévision scientifique, fondée sur une loi (ou encore un fait général) de la prévision actuarielle, fondée sur une loi de probabilité supposée gouverner la fréquence avec laquelle une classe d'événements se réalise.

Le psychologue intéressé par le conseil individuel se trouve dans une situation embarrassante s'il ne dispose pas de faits généraux ou s'il est consulté pour des choix ponctuels. Il serait alors bien avisé de ne pas invoquer des lois de probabilité occultes et de centrer son intervention sur l'affirmation de ce que ces données lui disent en termes de possibilités.

Le psychologue intéressé par les phénomènes de masse a tout intérêt à collecter des observations de manière à disposer d'une appréciation sensible des fréquences à l'aide de courbes de fréquences. En particulier, rien n'exclut que des tendances évoluent.

4. Mesurage : logique et usage

Objectifs Analyser le rôle du mesurage dans la recherche psychologique.

Prérequis.

Résumé. Cet article a pour objectif d'identifier, à partir d'un exemple, les erreurs logiques qui sous-tendent l'utilisation des scores comme mesures de grandeurs psychologiques.

4.1. Introduction

Le terme "mesurage" désigne l'action de mesurer. Du point de vue grammatical, le verbe "mesurer" est un verbe transitif direct, c'est-à-dire qu'il appelle un complément d'objet direct. Autrement dit, si on dit "je mesure", il faut compléter la phrase en indiquant ce qui est mesuré. Du point de vue sémantique, ce qui est mesuré est par définition une grandeur. Par exemple, si je dis "je mesure la taille de Paul", la taille de Paul est une grandeur.

En psychologie, le verbe "mesurer" est largement utilisé. Le problème qui nous intéresse ici est de savoir si cet usage est logiquement cohérent. Par exemple, si l'usage en psychologie est qu'on mesure l'attachement d'une personne à son quartier, alors le fait de se demander si cette personne est plus attachée à son quartier aujourd'hui qu'il y a trois ans entre en droit dans le cadre de l'activité du psychologue. Mais pour que cet usage puisse se prévaloir de la scientificité, il faut encore qu'il ne souffre pas d'incohérence logique.

Le problème général que posent l'usage et l'enseignement du mesurage en psychologie est qu'il existe de sérieux problèmes de cohérence logique. De plus, ces problèmes ne sont pas appréhendés correctement parce que l'enseignement méthodologique en psychologie néglige généralement de poser le problème philosophique du rôle de la rationalité dans la démarche scientifique. Or, dans les sciences empiriques, la connaissance repose sur l'exercice de la raison et sur l'observation. Lorsque le mesurage, qui est une forme particulière de l'observation, repose sur des conventions irrationnelles ou encore illogiques, son utilisation s'expose au risque de fraude (Atlan, 2010), c'est-à-dire d'une affirmation délibérée de pseudo-vérités scientifiques. Une parade obscurantiste à l'accusation de fraude scientifique consiste à nier la possibilité d'affirmer une quelconque vérité scientifique. Mais cette position est intenable puisque si elle est vraie, elle est contradictoire (il est vrai qu'il n'y a pas de vérité) ; et si, parce qu'on veut éviter la contradiction, elle est fausse, alors elle est frauduleuse puisqu'elle est énoncée comme une vérité alors même qu'on sait que l'affirmation est fausse.

Le psychologue qui croit en la possibilité d'un savoir scientifique en psychologie est donc moralement tenu d'examiner la cohérence des pratiques et des discours qui procèdent de sa discipline. Cela vaut en particulier pour le mesurage.

4.2. Confusions et mystères

Nous prendrons pour exemple l'article de Rioux et Mokounkolo (2004), qui s'intitule "Attachement au quartier et adolescence. Étude comparative dans deux banlieues à forte diversité culturelle". On aura compris que le complément d'objet direct du verbe mesurer est ici "l'attachement au quartier des adolescents". La question de départ consiste donc à savoir si le mesurage de l'attachement au quartier d'une personne quelconque procède d'une démarche rationnelle.

Avant de répondre, assurons-nous de la réalité de l'usage en collectant quelques occurrences du verbe "mesurer" dans l'article. Nous trouvons le matériau suivant :

"En effet, mesuré à travers ses dimensions sociale et physique, l'attachement au quartier est plus intense que celui lié au logement et à la ville, la composante sociale étant la plus marquée" (p. 612).

Ainsi, l'attachement au quartier se mesure. Laissons de côté ce qu'il faut entendre par "à travers ses dimensions sociale et physique". Il s'agit bien d'une grandeur, puisqu'il peut être dit que l'attachement au quartier possède une intensité , et que cette intensité peut être comparée à l'intensité de l'attachement au logement et à l'intensité de l'attachement à la ville.

Nous aurons donc à examiner comment on fait pour mesurer l'intensité de l'attachement au quartier de quelqu'un. On trouve une autre occurrence du verbe mesurer un peu plus loin dans le texte :

"Cette échelle est composée de six items, dont deux mesurent le processus d'attachement au quartier, et quatre ses conséquences" (p. 613).

Cette phrase est riche de renseignements. Dans l'introduction, nous avons explicité que le verbe mesurer appelle un complément d'objet direct (COD) et que ce COD dénote par définition une grandeur. Mais nous n'avions pas jugé utile de préciser que le sujet du verbe mesurer est nécessairement un être humain. Ici, le verbe mesurer a deux sujets, "deux items", et "quatre items". Cette utilisation du verbe mesurer est incohérente. Le mesurage est une opération qui est effectuée par un être humain, c'est-à-dire par quelqu'un qui a une intention particulière bien qu'elle puisse être implicite, et avec un instrument ou un procédé particulier.

Ainsi, les auteurs ont l'intention de mesurer quelque chose avec des items de questionnaire. Mais, pourra-t-on se demander, en quoi un item de questionnaire peut-il s'apparenter à un procédé ou encore à une opération ? Cette formulation prête aux items la faculté de mesurer quelque chose. Ce qui constitue un authentique mystère, parce qu'un item est un ensemble de symboles couchés sur une feuille de papier ou sur un écran d'ordinateur -- une consigne, une description, et une échelle d'appréciation. Aucun principe actif dans une suite de symboles. Les auteurs escamotent la question du principe opératoire sur lequel pourrait reposer le mesurage de l'attachement au quartier -- affirmer cela serait abusif si la question était traitée ailleurs dans l'article, mais il se trouve qu'elle n'est pas abordée. Le principe du mesurage est contenu dans la capacité de la personne (à qui on demande d'apprécier les descriptions figurant dans les items du test) à produire une réponse. Mais cette capacité est une capacité linguistique. On se demande alors en quoi le fait de savoir lire et parler, et notamment de soi, permet de déterminer l'intensité de l'attachement au quartier du locuteur. Les auteurs sont muets à ce sujet.

Remettons-nous la phrase en question sous les yeux : "Cette échelle est composée de six items, dont deux mesurent le processus d'attachement au quartier, et quatre ses conséquences" (p. 613).

Dans la même phrase, le verbe mesurer accepte deux COD. Le premier COD est "le processus d'attachement au quartier". Ici, force est de constater que l'utilisation du verbe mesurer est sémantiquement impropre, puisqu'un processus n'est pas une grandeur. D'une manière générale, un processus est un ensemble de transformations qui s'opèrent sur des objets, et la notion de processus d'attachement au quartier est indéterminée puisqu'on ne sait pas quels objets sont transformés ni par quelles opérations. Il est cependant possible d'interpréter la proposition si on remplace le terme "processus" par le terme "intensité", sachant que l'intensité actuelle de l'attachement au quartier peut résulter d'un processus.

On aurait alors les phrases :

Cette échelle est composée de six items. Avec deux d'entre eux, nous obtenons les réponses de la personne interrogée, et nous déterminons, par un certain procédé, l'intensité de son attachement au quartier (comprise comme le résultat d'un processus psychologique mal connu).

Quels sont ces deux items qui permettent de mesurer l'attachement au quartier et non pas les conséquences de l'attachement au quartier ? Ici, nous sommes perdus. Les items en question (sauf la consigne qui n'a pas besoin d'être explicitée) sont listés ci-dessous.

- Pour y vivre, c'est le quartier idéal (1 : tout à fait en désaccord, 2, 3, 4, 5 : tout à fait d'accord).

- Ce quartier fait partie de moi-même (1 : tout à fait en désaccord, 2, 3, 4, 5 : tout à fait d'accord).

- Je suis très attaché(e) à certains endroits de ce quartier (1 : tout à fait en désaccord, 2, 3, 4, 5 : tout à fait d'accord).

- Il me serait très difficile de quitter définitivement ce quartier (1 : tout à fait en désaccord, 2, 3, 4, 5 : tout à fait d'accord).

- Je pourrais facilement quitter ce quartier (1 : tout à fait en désaccord, 2, 3, 4, 5 : tout à fait d'accord).

- Je n'aimerais pas à avoir à quitter ce quartier pour un autre (1 : tout à fait en désaccord, 2, 3, 4, 5 : tout à fait d'accord).

Ce qui suit n'est pas très important puisque nous avons compris que nous ne saurons pas comment il est possible de mesurer scientifiquement l'attachement au quartier. Le second COD désigne "les conséquences" du "processus d'attachement au quartier". En logique, une conséquence se déduit d'une prémisse. Peut-on identifier deux items (a, b) parmi les six proposés tels que la description contenue dans l'item a soit la conséquence de la description contenue dans l'item b ?

L'affirmation 1 n'implique aucune des affirmations 2 à 6, parce qu'on peut toujours trouver qu'il est possible d'avoir "1 = vrai" et "n'importe quelle autre affirmation = faux". Même situation pour la 2.

La 3 implique la 2 : si on est très attaché à certains endroits de son quartier, par définition, ce quartier "fait partie" de soi-même. Nous sommes néanmoins mal à l'aise avec l'argument "par définition" tant les notions sont floues. Si le quartier ne fait pas partie de moi-même, comment pourrais-je y être très attaché ? La négation de la 2 implique la négation de la 3. Donc la 3 implique la 2. ("A → B" est équivalent à "non B → non A")

La 4 implique la négation de la 5. La 5 implique la négation de la 4 et aussi la négation de la 6.

La 6 n'implique ni la 1, ni la 2 ni la 3 : en effet, dans ce dernier cas, qui paraît ambigu, il est possible de ne pas aimer à avoir à quitter le quartier pour un autre (affirmation de la 6) tout en n'étant pas très attaché à certains de ses endroits (négation de la 3), par exemple pour des raisons d'emplacement géographique qui font qu'on préfère y rester tout en étant attaché à aucun de ses endroits. Par contre, la 6 implique la 4 et la négation de la 5.

Récapitulons ces relations :

- 3 → 2,

- 4 → ˜5,

- 5 → ˜4 & ˜6,

- 6 → 4 & ˜5.

(On aura compris que la notation ˜ dénote la négation.) Il s'avère que cette analyse n'est pas cohérente avec celle des auteurs et que leur analyse demeure pour nous une obscurité. Les analyses qui précèdent ne permettent toujours pas de savoir comment l'intensité de l'attachement du quartier est déterminée en fonction des appréciations produites par la personne testée.

4.3. Le type à la place de la personne

Examinons à présent comment l'idée de grandeur est utilisée. On trouve d'autres propositions qui attestent que l'attachement au quartier s'appréhende comme une intensité :

- "Nous postulons donc que l'attachement au quartier sera plus intense en début qu'en fin d'adolescence" (p. 613).

- "[...] les femmes s'attacheraient davantage à leur quartier que les hommes" (p. 613).

- "[...] un attachement au quartier plus intense chez les jeunes filles que chez les jeunes hommes (p. 613).

L'attachement au quartier est conçu comme une grandeur mesurée de manière ordinale, c'est-à-dire que les auteurs s'intéressent à des comparaisons (plus que, moins que). D'un point de vue syntaxique, les propositions pertinentes ont la forme suivante :

L'intensité de l'attachement au quartier de X est plus grande ou plus petite que l'intensité de l'attachement au quartier de Y.

La question est alors de savoir ce que recouvrent les variables X et Y. "Les jeunes en début ou en fin d'adolescence" ne désignent personne en particulier, mais peut-être cette appellation désigne-t-elle quiconque de manière générale.

Précisons le sens de ces derniers termes à l'aide d'un exemple. Considérons l'ensemble {a, b, c, d, e}. L'élément e est un élément particulier en ce sens qu'il n'est pas a ni b par exemple. L'élément e est un élément quelconque en ce sens que j'aurais pu considérer n'importe quel autre élément de cet ensemble. Dans cette seconde perspective, je ne m'intéresse pas à ce qui fait de e un objet particulier, il me suffit de savoir qu'il appartient à l'ensemble. L'ensemble fonctionne alors comme une classe d'équivalence, ou encore une classe de référence, c'est-à-dire que ses éléments sont équivalents du point de vue du critère qui permet de les inclure dans l'ensemble.

Relisons donc la première proposition. L'attachement au quartier ne réfère à personne en particulier. Mais nous savons déjà que l'attachement ne réfère pas non plus à un adolescent quelconque, puisqu'il n'est pas question de nier les singularités des personnes de la classe "adolescents", notamment du point de vue de la manière dont les adolescents particuliers sont attachés à leur quartier. L'attachement au quartier qui intéresse les chercheurs est l'attachement au quartier de deux abstractions, ou encore de deux types : le jeune en début d'adolescence, le jeune en fin d'adolescence. Ces entités ont la fonction de résumer de manière idéalisée des réalités disparates (cf. Desrosières, 2000).

Dans la seconde proposition, l'attachement réfère aux femmes et aux hommes. La locution "Les femmes" ne désigne ni un élément particulier ni un élément quelconque, mais un ensemble de personnes ayant la propriété d'être femme. De même pour "les hommes". Il est difficile de donner un sens à l'attachement au quartier d'un ensemble ou encore d'une catégorie . Si on s'intéresse à l'attachement au quartier d'un groupe de personnes, ce sera pour se demander s'il existe ou non des différences entre ces personnes. S'il n'en existe pas, alors les personnes du groupe ne seront plus particulières mais quelconques du point de vue de l'attachement au quartier -- c'est-à-dire qu'elles seront devenues interchangeables non seulement du point de vue du critère qui fait qu'elles appartiennent au groupe, mais encore du point de vue d'un autre critère logiquement indépendant du premier (cf. la distinction entre VI et VD).

Ici, l'attachement au quartier est une grandeur qui caractérise un ensemble, indépendamment du fait que les éléments qui composent cet ensemble soient interchangeables du point de vue de la grandeur. Nous comprenons la seconde proposition en remplaçant "les femmes" par "la femme typique" et "les hommes" par "l'homme typique". Mais alors la question qui se pose est de savoir qui sont ces types. La femme typique et l'homme typique n'existent pas dans la nature. Ce sont des constructions de la pensée. Nous venons de découvrir que les auteurs s'intéressent à l'attachement au quartier de personnes typiques et non pas de personnes réelles. Les chercheurs s'intéressent ici à la psychologie de types, par opposition à la psychologie des personnes réelles. Si les chercheurs étaient des sociologues, comme les sociologues définissent leur objet comme quelque chose qui transcende les personnes d'une société, la question du statut ontologique du type -- entité qui existe indépendamment de nous ? -- se poserait d'une autre manière. Il est probable cependant que la spécificité du social par rapport au psychologique ne se réduise pas à la notion statistique de typicité.

La troisième proposition s'interprète de la même manière : les auteurs s'intéressent à la jeune fille et au jeune homme typiques. Le problème qui se pose maintenant est de savoir comment on fait pour mesurer l'attachement au quartier de ces types.

4.4. Mesurer l'attachement au quartier d'un type

Pour mesurer l'attachement au quartier d'un type, on va d'abord construire ce type de manière à ce qu'il puisse être appréhendé empiriquement. Autrement dit, on veut matérialiser ce type. On peut identifier quatre étapes :

- On doit d'abord résoudre le problème du mesurage de l'attachement au quartier de quiconque à un moment quelconque, ce qui permettra de donner au résultat du mesurage le statut d'un événement empirique.

- Le procédé même du mesurage définit un espace d'échantillonnage (sampling space), c'est-à-dire l'ensemble de tous les événements élémentaires qui peuvent en principe se produire lorsqu'on fait une expérience de mesurage, c'est-à-dire lorsqu'on mesure l'attachement au quartier de quiconque à un moment quelconque (i.e., un point dans la population).

- On procède alors à l'échantillonnage, c'est-à-dire qu'on effectue un certain nombre de mesurages auprès d'un échantillon de points (i.e., de couples (personne, moment)).

- On choisit ensuite un indice de centralité (i.e., une statistique, comme le mode ou la moyenne) pour calculer la valeur prise par la statistique du type.

Avant d'entrer dans les détails, insistons sur le point suivant : connaître la valeur prise par la statistique associée à l'échantillon ne permet pas de régler complètement le problème de la matérialisation du type. Car le type correspond à une distribution de probabilité qui est par construction inconnue et inconnaissable. La statistique d'échantillon ne nous donnera donc qu'une image partielle du type. Le principe même du type est que cette image varie : il y a autant d'images que d'échantillons possibles, et on sait que ces échantillons sont différents les uns des autres, puisqu'il existe des différences individuelles du point de vue de ce qui est mesuré. Cette variabilité est ce qu'on appelle en statistique l'erreur d'échantillonnage, ou encore, au pluriel, les fluctuations d'échantillonnage (voir Population et échantillons).

Le problème de recherche est posé de telle manière que le type restera toujours inconnu d'un point de vue empirique, et qu'on parlera de lui en se fondant sur quelques-unes de ses images. En général, le chercheur en psychologie se contente d'une seule image. Du point de vue philosophique, le chercheur en psychologie s'intéresse ici à une fiction qui n'a pas la vocation de correspondre à quiconque à un instant quelconque. Son objet d'étude est un pur concept (i.e., il ne correspond pas à quoi que ce soit de réel, mais, en tant que concept, il constitue une réalité sociale, parfois très utile pour les stratèges de la vente et de la communication -- cf. la description des goûts de la mère de famille moyenne en matière d'alimentation).

Revenons donc au premier sous-problème à résoudre : mesurer l'attachement au quartier de quiconque à un moment quelconque. La solution est simple. On se donne les six questions d'attachement au quartier, ce qui permet de décrire quiconque répond aux questions à un moment quelconque. Ainsi, on règle le problème insoluble suivant : comment rendre le vécu observable ? Mais ne soyons pas naïfs, ce qui est observé n'est pas le vécu, mais un ensemble de réponses qui dépend pour une part du vécu de la personne et pour une part des questions qu'on lui pose et du format des réponses qu'on lui impose.

Prévenons un malentendu : le problème n'est pas que le domaine des observables soit contingent, c'est qu'on l'identifie avec le vécu. Si on veut étudier la psychologie des gens de manière scientifique, il faut bien s'appuyer sur des descriptions objectives (cf. Mesurer ou décrire ?). Mais si on veut étudier de manière objective le vécu de Paul par rapport à son quartier, alors on a un problème insurmontable, c'est qu'on ne peut pas se glisser dans son vécu. Le problème en psychologie est de cultiver la naïveté qui consiste à croire qu'on peut faire une science du subjectif grâce à ce qu'on appelle des mesures psychologiques. Aucun mesurage n'est capable d'atteindre le subjectif, pour des raisons non pas technologiques, mais logiques. Il n'est logiquement pas possible d'affirmer que A est égal à non A. Or le mesurage, en tant que forme particulière d'observation, est un processus d'objectivation. Le raisonnement qui précède a une conséquence étonnante : c'est qu'un questionnaire donne accès à un monde de réponses aux items du questionnaire. La technique du questionnaire permet éventuellement de développer une science des réponses à des questions. Et les réponses des gens aux items du questionnaire ne correspondent pas à l'intensité de l'attachement au quartier parce que cette notion dénote un vécu. La négation de ces limites logiques constitue une erreur scientifique. Cette erreur peut se transformer en attitude frauduleuse si on persiste dans l'erreur en toute connaissance de cause.

On dispose d'une technique pour recueillir des observations lorsqu'on interroge quiconque à un moment quelconque (négligeons la nécessité que cette personne soit disposée à ce moment pour bien vouloir répondre à nos questions). Partant, nous avons défini notre espace d'échantillonnage, à ne pas confondre avec l'échantillon : l'espace d'échantillonnage est l'ensemble de toutes les réponses possibles à notre questionnaire. Une réponse est la donnée des six réponses à notre questionnaire, c'est un 6-uplet (plus généralement, on parlera d'un vecteur ou d'un m-uplet, m indiquant le nombre de données contenues dans le vecteur). Par exemple, le 6-uplet (1, 2, 1, 3, 4, 1) est une réponse possible au questionnaire.

Le problème qui surgit immédiatement est qu'on ne sait pas traduire ce 6-uplet en degré d'intensité d'attachement au quartier. Ceci devrait nous faire douter du bien-fondé du projet de mesurage de l'intensité de l'attachement au quartier. Non seulement, le vécu n'est pas pénétrable, mais encore les observables qui résultent de la technique du questionnaire n'ont pas le caractère logique d'une grandeur. Face à ce problème, les chercheurs adoptent une solution symbolique (et non pas instrumentale ), qui prend ici la forme suivante :

- recoder les réponses de la question 5 à l'envers : 1 devient 5, 2 devient 4, etc. jusqu'à 5 devient 1;

- additionner les chiffres du 6-uplet.

On obtient ainsi un score d'attachement au quartier, et donc un nouvel espace d'échantillonnage qui est l'ensemble des nombres {6, 7, ..., 30} (cf. Score psychométrique).

Note. Rioux et Mokounkolo utilisent ce qu'on appelle des "scores factoriels", qui sont des nombres issus d'opérations arithmétiques complexes, dont la spécification repose sur les données d'un échantillon. Mais ces calculs ne modifient pas le caractère logiquement frauduleux du mesurage parce qu'ils reposent sur l'additivité des nombres qui codent les réponses aux questions des items, quand bien même personne ne sait ce que signifie l'addition des degrés de réponse constituant les échelles de réponse (pas du tout d'accord + tout à fait d'accord = ?).

Grâce à ce procédé symbolique, il est possible de sonder le type qui nous intéresse, par exemple "les jeunes filles", en interrogeant par exemple 200 jeunes filles satisfaisant ce qu'on appelle des critères d'inclusion (par exemple, avoir entre 12 et 25 ans). Concrètement parlant, un type comme "les jeunes filles" est un type trop vague, parce qu'il faut exclure les jeunes filles chinoises par exemple.

Ainsi équipé, le chercheur peut comparer le mode d'un échantillon de manifestations du type "les jeunes filles" au mode d'un échantillon de manifestations du type "les jeunes garçons". Ces deux modes servent de mesures de l'intensité de l'attachement au quartier des deux types, sachant que l'erreur d'échantillonnage empêche d'être tout à fait sûr que le résultat de la comparaison, par exemple, le fait que le premier mode soit supérieur au second, sera reproductible si on utilise deux autres échantillons.

4.5. Mesurage psychologique et irrationnalité

Notre point de départ consistait à exiger l'absence d'incohérence logique dans la démarche scientifique, en particulier dans la démarche du mesurage d'une grandeur psychologique. L'exemple de l'étude de Rioux et Mokoukolo (2004) sur l'attachement au quartier des adolescents nous a permis d'identifier trois types d'incohérence logique et la promulgation de leur dénégation via une doctrine méthodologique devenue internationalement dominante depuis la fin de la moitié du XXe siècle (e.g., Danziger, 1990 ; Lamiell, 2003) :

- la dénégation de l'impossibilité logique de mesurer une grandeur subjective,

- la dénégation du caractère qualitatif et non ordinal de l'espace d'échantillonnage, utilisé à pleine puissance pour décrire les personnes et ensuite remplacé par un autre espace d'échantillonnage composé de scores,

- la dénégation des différences individuelles qui existent entre les personnes regroupées sous une catégorie et leur remplacement par la description, nécessairement partielle, du type qui les subsume.

Cette triple dénégation n'est pas gratuite. Elle permet de maintenir, en dépit des difficultés soulevées, le projet de mesurer des grandeurs psychologiques. Une telle attitude pourrait être décrite dans une perspective psychanalytique comme la dénégation du principe de réalité. Curieusement, un argument souvent opposé à la critique que nous avons développée est qu'il n'est pas réaliste de renoncer à la méthodologie mise en œuvre, de manière exemplaire, par Rioux et Mokounkolo (2004). Mais ce réalisme-là n'a pas grand-chose à voir avec l'éthique de la connaissance scientifique, qui refuse en particulier la toute puissance d'un utilitarisme dont les fondements ne sont pas toujours explicites (cf. Canguilhem, 1958).

Il est clairement réaliste de développer une science des réponses aux questionnaires psychologiques, si tant est que les questionnaires psychologiques constituent un mode d'objectivation privilégié en psychologie. Et il est parfaitement réaliste de considérer qu'une science empirique est par définition une science des phénomènes empiriques auxquels elle sait accéder (qu'elle sait décrire).

4.6. Exercices corrigés

Critiquer les affirmations suivantes du point de vue méthodologique. On pourra s'aider en utilisant les questions suivantes:

- Est-il question de personnes quelconques (si oui, dans quel ensemble de référence sont-elles regroupées), particulières (si oui, de qui s'agit-il), ou typiques (si oui, vérifier qu'elles ne sont ni quelconques, ni particulières) ?

- L'ensemble des valeurs des variables (grandeurs mesurées, ou caractéristiques descriptives) peut-il être spécifié (si oui, quel est-il) ?

Exercice 1. En moyenne, les fumeurs meurent plus jeunes que les non fumeurs.

La durée de vie peut se mesurer en années. Les fumeurs et les non fumeurs renvoient à des personnes typiques (il ne s'agit pas de comparer les durées de vie d'un fumeur et d'un non fumeur quelconques, ni d'un fumeur et d'un non fumeur particuliers -- Jean qui était fumeur peut très bien avoir vécu plus longtemps que Paul qui était non fumeur).

Exercice 2. On considère un questionnaire de deux items à 5 modalités de réponse (1, 2, ..., 5). Les gens étudiés dans une certaine condition C choisissent systématiquement les degrés 4 ou 5.

On décrit des personnes qui se trouvent dans la condition C. Ces personnes sont décrites dans l'ensemble {11, 12, 13, ..., 55}, qui comprend 5 × 5 = 25 couples de réponses possibles. Le phénomène décrit est remarquable, puisque les réponses d'une personne quelconque (ou, dit autrement, de toute personne sde trouvant dans la condition C) appartiennent au sous-ensemble {44, 45, 54, 55}, soit 4/25e de l'espace d'échantillonnage.

Exercice 3. Un chercheur utilise un questionnaire d'anxiété composé de 10 items cotés sur une échelle de quatre degrés d'accord. Le score d'anxiété de Paul est en moyenne plus élevé lorsque Paul est de mauvaise humeur.

Le chercheur mesure l'anxiété de Paul avec un questionnaire. Le score résulte d'un traitement symbolique des réponses de Paul au questionnaire. Il n'est pas exclu que ce traitement soulève des difficultés logiques puisqu'on ne sait pas en quoi un vecteur de réponses, c'est-à-dire la donnée des 10 réponses, pourrait représenter une quantité ou un degré. On ignore la taille des échantillons d'observations ainsi que la procédure qui permet de déterminer la qualité de l'humeur.

Exercice 4. La fréquence de la réponse "oui" à la question "Je me sens anxieux : oui ou non" est plus élevée lorsqu'on est de mauvaise humeur.

Un chercheur observe la réponse de quiconque à la question "Je me sens anxieux : oui ou non", selon l'humeur considérée comme "mauvaise" ou "non mauvaise". L'affirmation est évasive pour deux raisons :

- la taille de l'échantillon des réponses observées n'est pas précisée,

- la procédure de classification de l'humeur n'est pas précisée.

Exercice 5. Un chercheur mesure l'agressivité de joueurs de jeux video qu'il a affecté au hasard à deux conditions expérimentales. Les joueurs qui jouent à des jeux video violents sont plus agressifs que les joueurs qui jouent à des jeux video non violents.

Il s'agit de joueurs typiques -- des joueurs expérimentaux --, dont on décrit l'agressivité de façon évasive. On ne sait pas par quel procédé l'agressivité est mesurée. Si l'espace d'échantillonnage est constitué de plusieurs items (par exemple, proférer des injures, frapper le clavier), une observation est un vecteur. D'où le problème de savoir comment représenter des vecteurs sur une échelle.

5. Opérationnaliser une grandeur psychologique

Objectifs Montrer comment un score peut être interprété comme la mesure d'un construit et en quoi cette interprétation ne peut pas être une explication scientifique.

Prérequis.

Résumé. Selon l'article intitulé "Relations entre Statistique et Psychométrie" (§ 3, cours de L1), la psychométrie s'occupe de la conceptualisation des scores obtenus à l'aide de tests ou questionnaires psychométriques. Pourquoi conceptualiser les scores psychométriques ? Si on ne connaissait pas de possibilité pour interpréter les scores comme mesures d'une grandeur hypothétique, il serait impossible d'utiliser les scores comme des mesures de quoi que ce soit.

5.1. Les scores psychométriques sont des artefacts

Dans un ouvrage critique, Kurt Danziger (1990) écrit ceci :

But in truth scientific psychology does not deal in natural objects. It deals in test scores, rating scales, response distributions, serial lists, and innumerable other items that the investigator does not find but constructs with great care. Whatever guesses are made about the natural world are totally constrained by this world of artifacts (p. 2).

Ce que nous traduirons comme cela :

Mais, en vérité, la psychologie scientifique n'a pas affaire à des objets naturels. Elle a affaire à des scores psychométriques, à des échelles de réponse, à des distributions de réponses, à des listes ordonnées, et à d'innombrables choses de ce genre, que les chercheurs ne trouvent pas, mais élaborent soigneusement. Quelles que soient les conjectures qui sont faites à propos du monde naturel, elles sont totalement déterminées par cet univers d'artefacts.

Quand on y regarde de près, c'est évident : les scores psychométriques ne sont pas des données, mais des artefacts. Ce sont des événements constitués dans un univers artificiel, c'est-à-dire un univers qui est fabriqué (par les psychologues).

Par conséquent, le psychologue est tenu de connaître les procédés de fabrication des scores psychométriques, car il est supposé compétent pour répondre de leur signification. L'article intitulé "Score psychométrique" (cours de L1) décrit en détail comment les scores de tests sont fabriqués.

Les scores de tests ont une double signification. Lorsqu'on regarde comment ils sont fabriqués, ils correspondent à des classes de réponses. Lorsqu'on regarde ce qu'ils sont supposés représenter, ils correspondent à des différences relatives à une grandeur métaphorique, un "construit" (e.g., l'anxiété-trait).

Leur signification opératoire pose un problème de cohérence. Leur signification métaphorique pose également un problème de cohérence. Ces problèmes sont généralement ignorés (méconnus ou négligés) par leurs utilisateurs. Tout se passe comme si les scores psychométriques étaient sinon des mesures, du moins des données quantitatives prêtes à être introduites dans des analyses statistiques. Les problèmes de cohérence opératoire des scores psychométriques sont développés dans l'article La confusion nominale induite par les scores psychométriques.

Le présent article se focalise sur les problèmes de cohérence métaphorique des scores psychométriques et introduit les solutions interprétatives de la théorie classique des tests et de la modélisation de la réponse à l'item. Une solution interprétative est une solution fondée sur une interprétation, c'est-à-dire sur l'invention d'une possibilité de se figurer comment il est possible d'observer ce qu'on observe. Elle s'oppose à une explication scientifique, qui non seulement explicite comment il est possible d'observer ce qu'on observe, mais encore comment il est nécessaire qu'on observe ce qu'on observe et pas autre chose. (Pour approfondir, voir Vautier, Veldhuis, Lacot, & Matton, 2012).

5.2. Comment passer du discret au continu ?

Considérons un questionnaire d'anxiété-trait dont l'échelle de scores varie de 0 à 40 points. Les scores sont obtenus par l'addition des 10 scores élémentaires obtenus aux 10 questions du test d'anxiété, chaque score élémentaire variant dans la suite (0, 1, 2, 3, 4). On remarque immédiatement qu'il est impossible d'observer le score 2,3 points par exemple, du fait de la conception même du score psychométrique. Donc, d'un point de vue empirique, la grandeur varie dans la suite (0, 1, ..., 40), c'est-à-dire qu'il y a 40 sauts (le saut de 0 à 1, le saut de 1 à 2, etc.).

Or, d'un point de vue métaphorique, l'anxiété-trait n'est pas une grandeur discrète, mais continue. Un continuum est une grandeur telle qu'on passe d'un niveau à un autre sans saut. L'intuition psychologique selon laquelle l'anxiété-trait serait comme un attribut quantitatif ne spécifie ni sauts ni paliers. Par défaut, cet attribut quantitatif est donc un continuum. D'où un problème logique : comment peut-on mesurer, c'est-à-dire mettre en correspondance, une grandeur continue avec 41 paliers ?

La théorie classique des tests définit le continuum [0, 40], dans lequel variera le "score vrai", tandis que la modélisation de la réponse à l'item définit un continuum non borné (i.e., l'ensemble des nombres réels), dans lequel variera le "trait latent". Ces deux vocables constituent des constructions quantitatives mobilisées pour opérationnaliser l'intuition d'une grandeur psychologique continue.

5.3. La solution de la théorie classique des tests

1) Prenez quelqu'un, demandez-lui de répondre au questionnaire, calculez son score et enregistrez-le.

2) Effacez-lui la mémoire.

3) Assurez-vous que les conditions expérimentales n'ont pas changé.

4) Demandez-lui de répondre au questionnaire, calculez son score et enregistrez-le.

5) Recommencez les opérations 2, 3 et 4 toute votre vie, et si possible ne mourez jamais car la série de vos scores doit être infinie.

6) Lorsque vous avez fini de recueillir vos scores, calculez la moyenne : vous venez de découvrir le score vrai.

Ce score, qu'on appelle aussi une espérance mathématique, est une impossibilité empirique, une pure vue de l'esprit. Cela est obligatoire, puisque l'anxiété-trait est aussi une pure vue de l'esprit. Ainsi, une vue de l'esprit de caractère mathématique opérationnalise une vue de l'esprit de caractère métaphorique. Une simulation illustrative est disponible dans l'article Variable aléatoire (cours de L1).

À partir de là, toute l'histoire consiste à trouver comment on peut estimer la précision avec laquelle on estime le score vrai. Notons au passage qu'on ne mesure plus, on estime. C'est-à-dire qu'on se livre à de savants développements de l'opérationnalisation initiale, développements qu'on pourrait appeler théorie de la fidélité.

Pour l'instant, ce qui nous intéresse, c'est comprendre comment les scores peuvent être interprétés, à rebours, comme ce qui a résulté d'un processus de mesure. Pour donner une signification opératoire au score vrai, on le déduit d'une série de scores qu'on a obtenus par une expérience de pensée. Maintenant, on se passe de tout score observé et on considère qu'il y a le score vrai : il existe indépendamment de la série des mesures. Ce faisant, on fait appel à un postulat métaphysique, ce qui permet de dépasser le paradoxe du caractère non opératoire d'une chose définie par le biais d'une expérience de pensée. Maintenant, le score vrai est premier, il ne résulte plus de la moyenne des mesures.

Ensuite, il y a le mesurage, qui engendre des biais. Ces biais s'ajoutent donc au score vrai, ce qui donne le score observé. Notons que ce processus de mesurage est tout à fait magique. Et l'identification de la grandeur métaphorique avec le continuum est une pure convention. Écrivons cela de manière mathématique. Notons τ (tau) le score vrai, ε (epsilon) les biais et y le score observé. On a la définition suivante :

y = τ + ε.

Il faut maintenant montrer comment le score vrai peut varier sur le continuum [0, 40]. Pour cela, il suffit de faire un pas de plus dans l'écriture de la définition de τ . Ce pas va nous permettre de montrer comment est mobilisée une deuxième pure vue de l'esprit, corollaire de la première : la probabilité d'un événement (un score, étant donné le score vrai). On va considérer qu'il existe 41 probabilités :

1) la probabilité, étant donné

τ, d'obtenir le score 0, qui sera notée

p0,