t de student : Interpréter les sorties des logiciels SPSS 18, Statistica 8, R

Cette section présente les interprétations de sorties de différents logiciels pour...

- test t à échantillon unique

- test t à groupes appariés

- test t à groupes indépendants

Logiciels considérés : Jamovi, R, SPSS, Statistica, Tableurs

4. Formulaire Student

Avertissement : les formules présentées ici peuvent être sensiblement différentes en apparence à d'autres formules que vous pouvez trouver ailleurs.

Toutes ces formules sont généralement mathématiquement équivalentes et produisent les mêmes résultats.

Elles sont plus ou moins faciles à utiliser selon les informations dont vous disposez...

Le lecteur intéressé par les mathématiques de la chose pourra trouver une justification complète de tout cela dans l'excellent manuel de Howell

(en particulier le chapitre sur le test d'hypothèses appliqué aux moyennes).

A. Comparer la moyenne d'un échantillon et une constante de référence

Soit un échantillon de n mesures dont la moyenne est  et l'écart-type s.

et l'écart-type s.

On veut comparer la moyenne à une constante  qui représente une certaine moyenne théorique.

qui représente une certaine moyenne théorique.

où le nombre de degrés de liberté est ddl= n-1

Il faut encore calculer la taille de l'effet, qui pour les tests t est classiquement le d de Cohen. Ici,

- On détermine la valeur p d'avoir t(ddl)

- On utilise la valeur de p pour prendre une décision statistique

- On calcule la taille de l'effet

- On présente les résultats inférentiels

B. Comparer les moyennes de deux échantillons appariés

Soit un ensemble de n paires de mesures. On calcule une nouvelle variable constituant, pour chaque paire, la différence des deux mesures précédentes. Sous l'hypothèse nulle, la moyenne théorique de ces différences est zéro. La nouvelle variable constitue un échantillon unique dont la moyenne est  et l'écart-type

et l'écart-type  . On se ramène donc au cas d'une comparaison de moyenne (la moyenne des différences) et la constante

. On se ramène donc au cas d'une comparaison de moyenne (la moyenne des différences) et la constante  .

.

Il faut calculer la taille de l'effet, classiquement le d de Cohen. Ici, une formule simplifiée pour les groupes appariés le donne directement :

- On détermine la valeur p d'avoir t(ddl)

- On utilise la valeur de p pour prendre une décision statistique

- On présente les résultats inférentiels.

C. Comparer les moyennes de deux échantillons indépendants

Soient deux échantillons de mesures respectivement prises sur un groupe 1 de n1 sujets, et un groupe 2 de n2 sujets. Notons

,

et

,

et

les moyennes et écarts-types de ces deux échantillons.

les moyennes et écarts-types de ces deux échantillons.

La structure est la même pour tous les tests t : il s'agit de faire le rapport d'une différence de moyennes par une erreur standard. Dans le cas des mesures indépendantes, le calcul de l'erreur standard commune aux deux échantillons est compliqué par le fait que les effectifs des deux groupes peuvent différer (i.e.,  ).

).

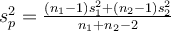

On commence par calculer une sorte de variance combinée des deux groupes, souvent notée  dans les ouvrages ("p" pour "pooled" en anglais), et qui corrige notamment le problème des tailles inégales :

dans les ouvrages ("p" pour "pooled" en anglais), et qui corrige notamment le problème des tailles inégales :

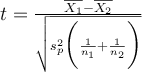

En prenant la racine de  on a un écart-type combiné, et on obtient alors t par la formule :

on a un écart-type combiné, et on obtient alors t par la formule :

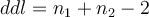

où le nombre de degrés de liberté :  .

.

Il faut encore calculer la taille de l'effet, qui pour les tests t est classiquement le d de Cohen. Ici, en nous appuyant sur le calcul de t déjà réalisé plus haut, nous disposons d'une formule qui marche même en cas d'échantillons d'effectifs différents :

- On détermine la probabilité p d'avoir t(ddl)

- On utilise la valeur de p pour prendre une décision statistique

- On présente les résultats inférentiels.

Couleur de fond

Police

Taille de police

Couleur de texte